Nøkkelen til å overvinne hindringer for AI-utvikling

Mer pålitelige data

Introduksjon

Kunstig intelligens begynte å fange fantasien da Tin Man fra «The Wizard of Oz» kom på skjermen i 1939, og den har bare fått et fastere fotfeste i tidsånden siden den gang. Når det gjelder bruk, har imidlertid AI-produkter gått gjennom vanlige boom-and-bust-sykluser som så langt har hindret de mest innflytelsesrike adopsjonene.

Under høykonjunkturene har ingeniører og forskere gjort enorme fremskritt, men når deres ambisjoner uunngåelig overgår datamulighetene som var tilgjengelige på den tiden, har en periode med dvale fulgt. Heldigvis har den eksponentielle økningen i datakraft som ble profetert av Moores lov i 1965 for det meste vist seg nøyaktig, og betydningen av denne økningen er vanskelig å overvurdere.

Les e-boken: nøkkelen til å overvinne hindringer for AI-utvikling, eller last ned en PDF-versjon av e-boken.

Nøkkelen til å overvinne AI-utviklingshindringer: Mer pålitelige data

I dag har en gjennomsnittlig person nå millioner av ganger mer datakraft i lomma enn NASA måtte gjennomføre månelandingen i 1969. Den samme allestedsnærværende enheten som praktisk demonstrerer en overflod av datakraft oppfyller også en annen forutsetning for AIs gullalder: en overflod av data. I følge innsikt fra Information Overload Research Group ble 90 % av verdens data opprettet i løpet av de siste to årene. Nå som den eksponentielle veksten i datakraft endelig har konvergert med like stor vekst i genereringen av data, eksploderer AI-datainnovasjoner så mye at noen eksperter tror vil sette i gang en fjerde industriell revolusjon.

Data fra National Venture Capital Association indikerer at AI-sektoren hadde en rekordstor investering på 6.9 milliarder dollar i første kvartal 2020. Det er ikke vanskelig å se potensialet til AI-verktøy fordi det allerede blir utnyttet rundt oss. Noen av de mer synlige brukstilfellene for AI-produkter er anbefalingsmotorene bak favorittapplikasjonene våre som Spotify og Netflix. Selv om det er morsomt å oppdage en ny artist å lytte til eller et nytt TV-program å overskue, er disse implementeringene ganske lave innsatser. Andre algoritmer vurderer testresultater – som delvis bestemmer hvor studenter blir tatt opp på college – og atter andre ser gjennom kandidat-CV'er og bestemmer hvilke søkere som får en bestemt jobb. Noen AI-verktøy kan til og med ha implikasjoner på liv eller død, for eksempel AI-modellen som screener for brystkreft (som overgår leger).

Til tross for jevn vekst i både virkelige eksempler på AI-utvikling og antallet startups som kjemper om å lage neste generasjon transformasjonsverktøy, gjenstår utfordringer for effektiv utvikling og implementering. Spesielt er AI-utdata bare så nøyaktig som inndata tillater, noe som betyr at kvaliteten er avgjørende.

Utfordringen med inkonsekvent datakvalitet i AI-løsninger

Det er virkelig en utrolig mengde data som genereres hver dag: 2.5 kvintillioner byte, ifølge Social Media Today. Men det betyr ikke at alt er verdig å trene algoritmen din. Noen data er ufullstendige, noen er av lav kvalitet, og noen er rett og slett unøyaktige, så bruk av denne feilaktige informasjonen vil resultere i de samme egenskapene fra din (dyre) AI-datainnovasjon. I følge forskning fra Gartner vil rundt 85 % av AI-prosjekter opprettet innen 2022 gi unøyaktige resultater på grunn av partiske eller unøyaktige data. Selv om du enkelt kan hoppe over en sanganbefaling som ikke passer din smak, har andre unøyaktige algoritmer en betydelig økonomisk og omdømmekostnad.

I 2018 begynte Amazon å bruke et AI-drevet ansettelsesverktøy, i produksjon siden 2014, som hadde en sterk og umiskjennelig skjevhet mot kvinner. Det viser seg at datamodellene som ligger til grunn for verktøyet ble opplært ved hjelp av CV-er som ble sendt til selskapet over et tiår. Fordi de fleste teknologisøkere var menn (og fortsatt er det, kanskje på grunn av denne teknologien), bestemte algoritmen seg for å straffe CV-er med "kvinners" inkludert hvor som helst - for eksempel fotballkaptein for kvinner eller forretningsgruppe for kvinner. Den bestemte seg til og med for å straffe søkerne ved to kvinneskoler. Amazon hevder at verktøyet aldri ble brukt som det eneste kriteriet for å evaluere potensielle kandidater, men rekrutterere så på anbefalingsmotoren når de lette etter nye ansatte.

Amazons ansettelsesverktøy ble til slutt skrotet etter mange års arbeid, men leksjonen henger igjen, og understreker viktigheten av datakvalitet når man trener algoritmer og AI-verktøy. Hvordan ser "høykvalitets"-data ut? Kort sagt, det merker av disse fem boksene:

1. Relevant

For å anses som høy kvalitet, må data bringe noe verdifullt inn i beslutningsprosessen. Er det en sammenheng mellom en jobbsøkers status som statsmester i stavhopp og deres prestasjoner på jobb? Det er mulig, men det virker svært usannsynlig. Ved å luke ut data som ikke er relevante, kan en algoritme fokusere på å sortere gjennom informasjonen som faktisk påvirker resultatene.

2. Nøyaktig

Disse dataene du bruker må representere ideene du tester nøyaktig. Hvis ikke, er det ikke verdt det. For eksempel trente Amazon opp ansettelsesalgoritmen sin ved å bruke 10 års søker-cv, men det er uklart om selskapet bekreftet informasjonen som ble gitt på disse cv-ene først. Forskning fra referansesjekkingsselskapet Checkster viser at 78 % av søkerne lyver eller vil vurdere å lyve på en jobbsøknad. Hvis en algoritme tar anbefalingsbeslutninger ved å bruke en kandidats GPA, for eksempel, er det en god idé først å bekrefte ektheten til disse tallene. Denne prosessen vil ta tid og penger, men den vil også uten tvil forbedre nøyaktigheten til resultatene dine.

3. Riktig organisert og kommentert

Når det gjelder en ansettelsesmodell basert på CV, er merknader relativt enkelt. På en måte kommer en CV forhåndsannotert, selv om det uten tvil vil være unntak. De fleste søkere oppgir jobberfaringen sin under overskriften "Erfaring" og relevante ferdigheter under "Skills". Men i andre situasjoner, som for eksempel kreftscreening, vil dataene være mye mer varierte. Informasjon kan komme i form av medisinsk bildediagnostikk, resultatene av en fysisk screening, eller til og med en samtale mellom legen og pasienten om familiens helsehistorie og tilfeller av kreft, blant andre former for data. For at denne informasjonen skal bidra til en nøyaktig deteksjonsalgoritme, må den være nøye organisert og kommentert for å sikre at AI-modellen lærer å lage nøyaktige spådommer basert på de riktige slutningene.

4. Oppdatert

Amazon forsøkte å lage et verktøy som ville spare tid og penger ved å reprodusere de samme ansettelsesbeslutningene mennesker tar på langt kortere tid. For å gjøre anbefalingene så nøyaktige som mulig, må data holdes oppdatert. Hvis et selskap en gang demonstrerte en preferanse for kandidater med evnen til å reparere skrivemaskiner, for eksempel, ville disse historiske ansettelsene sannsynligvis ikke ha stor betydning for egnetheten til dagens jobbsøkere for noen form for rolle. Som et resultat vil det være lurt å fjerne dem.

5. Passende mangfoldig

Amazon-ingeniører valgte å trene en algoritme med en gruppe søkere som overveldende var mannlige. Denne avgjørelsen var en kritisk feil, og den blir ikke mindre alvorlig av det faktum at det var CVene selskapet hadde tilgjengelig på den tiden. Amazon-ingeniører kunne ha samarbeidet med anerkjente organisasjoner med lignende ledige stillinger som hadde fått flere kvinnelige jobbsøkere for å gjøre opp for mangelen, eller det kunne ha kunstig kutte ned antall CVer av menn for å matche antall kvinner og trente og veiledet algoritmen med en mer nøyaktig representasjon av befolkningen. Poenget er at data mangfold er nøkkelen, og med mindre det gjøres en samlet innsats for å eliminere skjevhet i input, vil skjev utgang råde.

Det er klart at data av høy kvalitet ikke bare dukker opp fra ingensteds. I stedet må den kureres nøye med de tiltenkte resultatene i tankene. I AI-feltet sies det ofte at "søppel inn betyr søppel ut." Dette utsagnet er sant, men det undervurderer noe viktigheten av kvalitet. AI kan behandle utrolige mengder informasjon og gjøre den om til hva som helst, fra aksjevalg til ansettelsesanbefalinger til medisinske diagnoser. Denne kapasiteten overgår langt menneskets evner, noe som også betyr at den forstørrer resultatene. En forutinntatt menneskelig rekrutterer kunne bare overse så mange kvinner, men en partisk AI-rekrutterer kunne overse dem alle. I den forstand betyr søppel inn ikke bare søppel ut - det betyr at en liten mengde "søppel"-data kan bli til et helt deponi.

Navigere i komplekse samsvarskrav

Som om det ikke var vanskelig nok å finne kvalitetsdata, er noen av bransjene som kan tjene mest på AI-datainnovasjoner også de strengest regulerte. Helsevesenet er kanskje det beste eksemplet, og mens en undersøkelse fra HIT Infrastructure fant at 91 % av industriinnsidere tror teknologien kan forbedre tilgangen til pleie, er den optimismen dempet av det faktum at 75 % ser det som en trussel mot pasientsikkerhet og personvern. – og pasienter er ikke de eneste i faresonen.

De omfattende forskriftene som er vedtatt gjennom Health Insurance Portability and Accountability Act, krysser nå ulike lokale hindringer for dataoverholdelse som Europas generelle databeskyttelsesforordning, California Consumer Privacy Act i USA og personopplysningsloven i Singapore. Disse lokale forskriftene vil få selskap av mange flere, og ettersom telehelse fremstår som en mer betydningsfull kilde til helsedata, er det sannsynlig at regelverket vil få et enda strammere grep om pasientdata under transport. Som et resultat vil Shaips sikre og kompatible skyplattform vise seg å være et enda mer verdifullt middel for å samle og få tilgang til helsedata for å trene AI-produkter.

Personlig identifiserbar informasjon kan være en betydelig trussel mot AI-utviklingen din, men selv en fullstendig kompatibel implementering er i fare hvis den ikke kan levere den typen nøyaktige resultater som bare kommer med forskjellige treningsdata. En studie fra 2020 i Journal of the American Medical Association viste at maskinlæringsalgoritmer i det medisinske feltet oftest trenes med data fra pasienter i California, New York og Massachusetts. Gitt at disse pasientene representerer mindre enn en femtedel av den amerikanske befolkningen, for ikke å si noe om resten av verden, er det vanskelig å forestille seg hvordan disse modellene kan gi noe annet enn partiske resultater.

Overvinne hindringer for AI-utvikling

AI-utviklingsarbeid inkluderer betydelige hindringer uansett hvilken bransje de finner sted i, og prosessen med å komme fra en gjennomførbar idé til et vellykket produkt er full av vanskeligheter. Mellom utfordringene med å skaffe de riktige dataene og behovet for å anonymisere dem for å overholde alle relevante forskrifter, kan det føles som å faktisk konstruere og trene en algoritme er den enkle delen.

For å gi organisasjonen din alle nødvendige fordeler i arbeidet med å designe en banebrytende ny AI-utvikling, bør du vurdere å samarbeide med et selskap som Shaip. Chetan Parikh og Vatsal Ghiya grunnla Shaip for å hjelpe bedrifter med å utvikle den typen løsninger som kan forvandle helsevesenet i USA. Etter mer enn 16 år i virksomhet har selskapet vokst til å omfatte mer enn 600 teammedlemmer, og vi har jobbet med hundrevis av kunder for å gjøre overbevisende ideer om til AI-løsninger.

Med våre ansatte, prosesser og plattformer som jobber for organisasjonen din, kan du umiddelbart låse opp følgende fire fordeler og kaste prosjektet mot en vellykket avslutning:

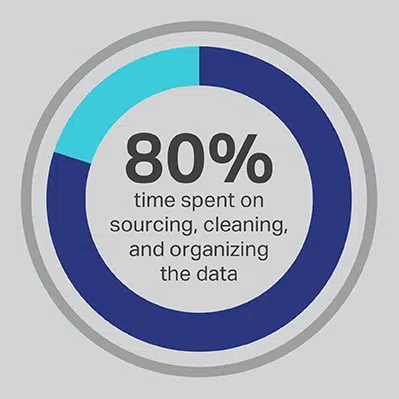

1. Kapasiteten til å frigjøre dataforskerne dine

Det er ingen vei utenom at AI-utviklingsprosessen tar en betydelig investering av tid, men du kan alltid optimalisere funksjonene som teamet ditt bruker mest tid på å utføre. Du ansatte dataforskerne dine fordi de er eksperter på utvikling av avanserte algoritmer og maskinlæringsmodeller, men forskningen viser konsekvent at disse arbeiderne faktisk bruker 80 % av tiden sin på å hente inn, rense og organisere dataene som skal drive prosjektet. Mer enn tre fjerdedeler (76 %) av dataforskerne rapporterer at disse verdslige datainnsamlingsprosessene også tilfeldigvis er deres minst favorittdeler av jobben, men behovet for kvalitetsdata etterlater bare 20 % av tiden deres til faktisk utvikling, som er det mest interessante og intellektuelt stimulerende arbeidet for mange dataforskere. Ved å skaffe data gjennom en tredjepartsleverandør som Shaip, kan et selskap la sine dyre og talentfulle dataingeniører outsource arbeidet sitt som datavaktmestere og i stedet bruke tiden sin på de delene av AI-løsningene der de kan produsere mest verdi.

2. Evnen til å oppnå bedre resultater

Å stole på åpen kildekode-data er en annen vanlig snarvei som kommer med sitt eget sett med fallgruver. Mangel på differensiering er et av de største problemene, fordi en algoritme som er trent ved bruk av åpen kildekode-data, er lettere å replikere enn en bygd på lisensierte datasett. Ved å gå denne ruten inviterer du til konkurranse fra andre aktører i området som kan underby prisene dine og ta markedsandeler når som helst. Når du stoler på Shaip, får du tilgang til data av høyeste kvalitet samlet av en dyktig administrert arbeidsstyrke, og vi kan gi deg en eksklusiv lisens for et tilpasset datasett som hindrer konkurrenter i å enkelt gjenskape din hardt vunnede intellektuelle eiendom.

3. Tilgang til erfarne fagfolk

Med domeneeksperter som identifiserer, organiserer, kategoriserer og merker data for deg, vet du at informasjonen som brukes til å trene algoritmen din kan gi best mulig resultater. Vi gjennomfører også regelmessig kvalitetssikring for å sikre at data oppfyller de høyeste standardene og vil fungere etter hensikten, ikke bare i et laboratorium, men også i en virkelig situasjon.

4. En akselerert utviklingstidslinje

AI-utvikling skjer ikke over natten, men det kan skje raskere når du samarbeider med Shaip. Intern datainnsamling og merknader skaper en betydelig operasjonell flaskehals som holder opp resten av utviklingsprosessen. Å jobbe med Shaip gir deg umiddelbar tilgang til vårt enorme bibliotek med klar-til-bruk data, og ekspertene våre vil kunne hente alle slags tilleggsdata du trenger med vår dype bransjekunnskap og globale nettverk. Uten byrden med innkjøp og merknader kan teamet ditt begynne å jobbe med faktisk utvikling med en gang, og opplæringsmodellen vår kan bidra til å identifisere tidlige unøyaktigheter for å redusere gjentakelsene som er nødvendige for å nå nøyaktighetsmålene.

Hvis du ikke er klar til å outsource alle aspekter av dataadministrasjonen din, tilbyr Shaip også en skybasert plattform som hjelper team med å produsere, endre og kommentere ulike typer data mer effektivt, inkludert støtte for bilder, video, tekst og lyd . ShaipCloud inkluderer en rekke intuitive validerings- og arbeidsflytverktøy, for eksempel en patentert løsning for å spore og overvåke arbeidsbelastninger, et transkripsjonsverktøy for å transkribere komplekse og vanskelige lydopptak, og en kvalitetskontrollkomponent for å sikre kompromissløs kvalitet. Det beste av alt er at det er skalerbart, så det kan vokse etter hvert som de ulike kravene til prosjektet ditt øker.

Tiden for AI-innovasjon har bare så vidt begynt, og vi vil se utrolige fremskritt og innovasjoner i de kommende årene som har potensial til å omforme hele bransjer eller til og med endre samfunnet som helhet. Hos Shaip ønsker vi å bruke ekspertisen vår til å tjene som en transformativ kraft, og hjelpe de mest revolusjonerende selskapene i verden med å utnytte kraften til AI-løsninger for å oppnå ambisiøse mål.

Vi har dyp erfaring innen helseapplikasjoner og samtale-AI, men vi har også de nødvendige ferdighetene til å trene modeller for nesten alle typer applikasjoner. For mer informasjon om hvordan Shaip kan hjelpe deg med å ta prosjektet ditt fra idé til implementering, ta en titt på de mange ressursene som er tilgjengelige på nettsiden vår eller ta kontakt med oss i dag.