Hva er treningsdata i maskinlæring:

Definisjon, fordeler, utfordringer, eksempler og datasett

Den ultimate kjøperveiledningen 2023

Introduksjon

I en verden av kunstig intelligens og maskinlæring er dataopplæring uunngåelig. Dette er prosessen som gjør maskinlæringsmoduler nøyaktige, effektive og fullt funksjonelle. I dette innlegget utforsker vi i detalj hva AI-treningsdata er, treningsdatakvalitet, datainnsamling og lisensiering og mer.

Det er anslått at en gjennomsnittlig voksen tar beslutninger om livet og hverdagslige ting basert på tidligere læring. Disse kommer igjen fra livserfaringer formet av situasjoner og mennesker. I bokstavelig forstand er situasjoner, tilfeller og mennesker ingenting annet enn data som blir matet inn i tankene våre. Ettersom vi samler år med data i form av erfaring, har menneskesinnet en tendens til å ta sømløse beslutninger.

Hva formidler dette? Disse dataene er uunngåelige i læring.

I likhet med hvordan et barn trenger en etikett kalt et alfabet for å forstå bokstavene A, B, C, D trenger en maskin også å forstå dataene den mottar.

Det er akkurat det Artificial Intelligence (AI) trening handler om. En maskin er ikke annerledes enn et barn som ennå ikke har lært ting av det de skal læres. Maskinen vet ikke å skille mellom en katt og en hund eller en buss og en bil fordi de ennå ikke har opplevd disse elementene eller blitt lært hvordan de ser ut.

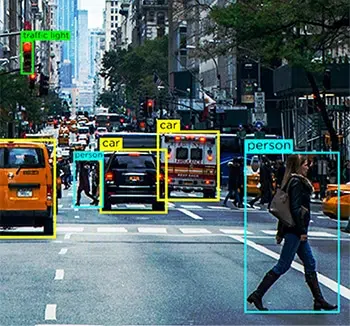

Så, for noen som bygger en selvkjørende bil, er den primære funksjonen som må legges til systemets evne til å forstå alle de hverdagslige elementene bilen kan møte, slik at kjøretøyet kan identifisere dem og ta passende kjørebeslutninger. Dette er hvor AI treningsdata kommer inn i bildet.

I dag tilbyr kunstig intelligensmoduler oss mange bekvemmeligheter i form av anbefalingsmotorer, navigasjon, automatisering og mer. Alt dette skjer på grunn av AI-datatrening som ble brukt til å trene algoritmene mens de ble bygget.

AI-treningsdata er en grunnleggende prosess i byggingen maskinlæring og AI-algoritmer. Hvis du utvikler en app som er basert på disse teknologikonseptene, må du trene systemene dine til å forstå dataelementer for optimalisert behandling. Uten trening vil AI-modellen din være ineffektiv, mangelfull og potensielt meningsløs.

Det er anslått at dataforskere bruker mer enn 80% av tiden i Data Preparation & Enrichment for å trene ML-modeller.

Så, for de av dere som ønsker å få finansiering fra venturekapitalister, soloprenørene der ute som jobber med ambisiøse prosjekter og teknologientusiaster som akkurat har begynt med avansert AI, har vi utviklet denne guiden for å hjelpe deg med å svare på de viktigste spørsmålene mht. dine AI-treningsdata.

Her vil vi utforske hva AI-treningsdata er, hvorfor er det uunngåelig i prosessen din, volumet og kvaliteten på data du faktisk trenger, og mer.

Hva er AI Training Data?

AI-treningsdata er nøye kurert og renset informasjon som mates inn i et system for treningsformål. Denne prosessen gjør eller ødelegger en AI-modells suksess. Det kan hjelpe med å utvikle forståelsen av at ikke alle firbeinte dyr i et bilde er hunder, eller det kan hjelpe en modell å skille mellom sinte roping og gledelig latter. Det er det første trinnet i å bygge kunstig intelligens-moduler som krever skje-matingsdata for å lære maskinene det grunnleggende og gjøre dem i stand til å lære etter hvert som mer data mates. Dette åpner igjen for en effektiv modul som gir ut nøyaktige resultater til sluttbrukere.

Vurder en AI-treningsdataprosess som en treningsøkt for en musiker, der jo mer de trener, jo bedre blir de på en sang eller en skala. Den eneste forskjellen her er at maskiner også først må læres hva et musikkinstrument er. I likhet med musikeren som gjør god bruk av de utallige timene som brukes på å øve på scenen, tilbyr en AI-modell en optimal opplevelse for forbrukerne når den brukes.

Hvorfor kreves AI-treningsdata?

Det enkleste svaret på hvorfor AI-treningsdata kreves for en modells utvikling, er at uten det ville maskinene ikke engang vite hva de skulle forstå i utgangspunktet. Som en person som er trent for sin spesielle jobb, trenger en maskin et korpus av informasjon for å tjene et bestemt formål og levere tilsvarende resultater.

La oss vurdere eksemplet med autonome biler igjen. Terabyte etter terabyte med data i et selvkjørende kjøretøy kommer fra flere sensorer, datasynsenheter, RADAR, LIDARer og mye mer. Alle disse massive databitene ville være meningsløse hvis det sentrale behandlingssystemet til bilen ikke vet hva de skal gjøre med det.

For eksempel, datasyn enhet av bilen kan være å spy ut mengder data på veielementer som fotgjengere, dyr, jettegryter og mer. Hvis maskinlæringsmodulen ikke er opplært til å identifisere dem, vil ikke kjøretøyet vite at de er hindringer som kan forårsake ulykker hvis de oppstår. Derfor må modulene trenes på hva hvert enkelt element i veien er og hvordan ulike kjørebeslutninger kreves for hver enkelt.

Selv om dette kun er for visuelle elementer, bør bilen også kunne forstå menneskelige instruksjoner gjennom Natural Language Processing (NLP) og lyd- eller talesamling og svare deretter. For eksempel, hvis sjåføren kommanderer infotainmentsystemet i bilen til å se etter bensinstasjoner i nærheten, bør det være i stand til å forstå kravet og gi passende resultater. For det bør den imidlertid kunne forstå hvert eneste ord i setningen, koble dem sammen og kunne forstå spørsmålet.

Selv om du kan lure på om prosessen med AI-treningsdata er komplisert bare fordi den er utplassert for en tung brukssituasjon som en autonom bil, er faktum at til og med den neste filmen Netflix anbefaler går gjennom den samme prosessen for å gi deg personlige forslag. Enhver app, plattform eller entitet som har AI knyttet til seg, drives som standard av AI-treningsdata.

Hvilke typer data trenger jeg?

Det er 4 primære typer data som vil være nødvendig, dvs. bilde, video, lyd/tale eller tekst for å effektivt trene maskinlæringsmodeller. Hvilken type data som trengs, vil være avhengig av en rekke faktorer, for eksempel brukssaken, kompleksiteten til modellene som skal trenes, opplæringsmetoden som brukes, og mangfoldet av inputdata som kreves.

Hvor mye data er tilstrekkelig?

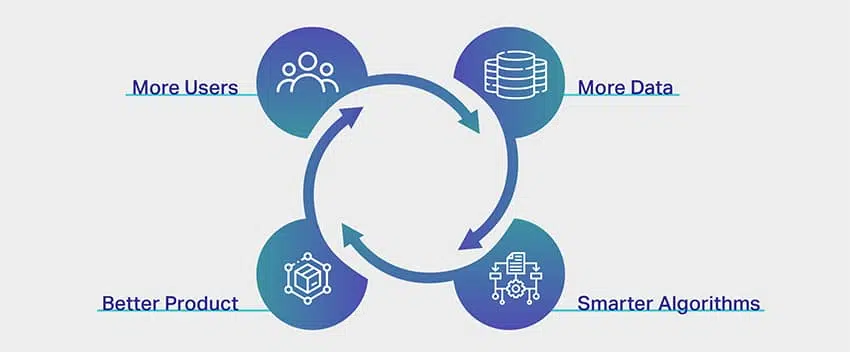

De sier at det ikke er slutt på læring, og denne setningen er ideell i AI-treningsdataspekteret. Jo flere data, jo bedre resultater. Et så vagt svar som dette er imidlertid ikke nok til å overbevise alle som ønsker å lansere en AI-drevet app. Men realiteten er at det ikke er noen generell tommelfingerregel, en formel, en indeks eller en måling av det nøyaktige volumet av data man trenger for å trene AI-datasettene sine.

En maskinlæringsekspert vil komisk avsløre at en separat algoritme eller modul må bygges for å utlede mengden data som kreves for et prosjekt. Det er dessverre også realiteten.

Nå er det en grunn til at det er ekstremt vanskelig å sette et tak på mengden data som kreves for AI-trening. Dette er på grunn av kompleksiteten involvert i selve opplæringsprosessen. En AI-modul består av flere lag med sammenkoblede og overlappende fragmenter som påvirker og utfyller hverandres prosesser.

La oss for eksempel vurdere at du utvikler en enkel app for å gjenkjenne et kokosnøtttre. Fra utsiktene høres det ganske enkelt ut, ikke sant? Fra et AI-perspektiv er det imidlertid mye mer komplekst.

Helt i starten er maskinen tom. Den vet ikke hva et tre er i utgangspunktet enn si et høyt, regionspesifikt, tropisk fruktbærende tre. For det må modellen læres opp i hva et tre er, hvordan man skiller seg fra andre høye og slanke gjenstander som kan vises i ramme som gatelys eller elektriske stolper, og deretter gå videre for å lære det nyansene til et kokosnøtttre. Når maskinlæringsmodulen har lært hva et kokosnøtttre er, kan man trygt anta at det vet hvordan man gjenkjenner et.

Men bare når du mater et bilde av et banyantre, vil du innse at systemet har feilidentifisert et banyantre for et kokosnøtttre. For et system er alt som er høyt med klynget løvverk et kokosnøtttre. For å eliminere dette, må systemet nå forstå hvert eneste tre som ikke er et kokosnøtttre for å identifisere nøyaktig. Hvis dette er prosessen for en enkel enveis app med bare ett resultat, kan vi bare forestille oss kompleksiteten involvert i apper som er utviklet for helsevesen, finans og mer.

Bortsett fra dette, hva påvirker også mengden data som kreves for opplæring inkluderer aspekter som er oppført nedenfor:

- Treningsmetode, hvor forskjellene i datatyper (strukturert og ustrukturert) påvirker behovet for datamengder

- Datamerking eller annoteringsteknikker

- Måten data mates til et system

- Feiltoleransekvotient, som ganske enkelt betyr prosentandelen av feil som er ubetydelige i din nisje eller domene

Eksempler fra den virkelige verden på treningsvolumer

Selv om mengden data du trenger for å trene modulene dine avhenger om prosjektet ditt og de andre faktorene vi diskuterte tidligere, litt inspirasjon eller referanse vil bidra til å få en omfattende idé om data krav.

Følgende er eksempler fra den virkelige verden på mengden datasett som brukes for AI-opplæringsformål av forskjellige selskaper og virksomheter.

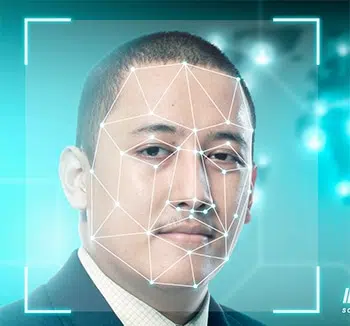

- Ansiktsgjenkjenning – en prøvestørrelse på over 450,000 XNUMX ansiktsbilder

- Bildekommentar – en prøvestørrelse på over 185,000 XNUMX bilder med nærmere 650,000 XNUMX kommenterte objekter

- Facebook-stemningsanalyse – en prøvestørrelse på over 9,000 kommentarer og 62,000 XNUMX innlegg

- Chatbot-trening – en prøvestørrelse på over 200,000 XNUMX spørsmål med over 2 millioner svar

- Oversettelses-app – en prøvestørrelse på over 300,000 XNUMX lyd eller tale samling fra personer som ikke har morsmål

Hva om jeg ikke har nok data?

I en verden av AI og ML er datatrening uunngåelig. Det sies med rette at det ikke er slutt på å lære nye ting, og dette gjelder når vi snakker om AI-treningsdataspekteret. Jo flere data, jo bedre resultater. Imidlertid er det tilfeller der brukssaken du prøver å løse, er knyttet til en nisjekategori, og det er en utfordring å skaffe riktig datasett i seg selv. Så i dette scenariet, hvis du ikke har tilstrekkelige data, kan det hende at spådommene fra ML-modellen ikke er nøyaktige eller kan være partiske. Det finnes måter som dataforsterkning og dataoppmerking som kan hjelpe deg med å overvinne manglene, men resultatet kan fortsatt ikke være nøyaktig eller pålitelig.

Hvordan forbedrer du datakvaliteten?

Kvaliteten på data er direkte proporsjonal med kvaliteten på utdata. Det er derfor svært nøyaktige modeller krever datasett av høy kvalitet for opplæring. Imidlertid er det en hake. For et konsept som er avhengig av presisjon og nøyaktighet, er kvalitetsbegrepet ofte ganske vagt.

Data av høy kvalitet høres sterke og troverdige ut, men hva betyr det egentlig?

Hva er kvalitet i utgangspunktet?

Vel, som selve dataene vi mater inn i systemene våre, har kvalitet mange faktorer og parametere knyttet til seg også. Hvis du henvender deg til AI-eksperter eller maskinlæringsveteraner, kan de dele enhver permutasjon av data av høy kvalitet.

- Uniform – data som er hentet fra én bestemt kilde eller enhetlighet i datasett som er hentet fra flere kilder

- Omfattende – data som dekker alle mulige scenarier systemet ditt er ment å jobbe med

- Konsekvent – hver enkelt byte med data er av lik natur

- Aktuell – dataene du henter inn og mater er lik dine krav og forventede resultater og

- Diverse – du har en kombinasjon av alle typer data som lyd, video, bilde, tekst og mer

Nå som vi forstår hva kvalitet i datakvalitet betyr, la oss raskt se på de forskjellige måtene vi kan sikre kvalitet på datainnsamling og generasjon.

1. Se opp for strukturerte og ustrukturerte data. Førstnevnte er lett forståelig av maskiner fordi de har kommenterte elementer og metadata. Sistnevnte er imidlertid fortsatt rå uten verdifull informasjon et system kan bruke. Det er her datakommentarer kommer inn.

2. Eliminering av skjevheter er en annen måte å sikre kvalitetsdata på ettersom systemet fjerner eventuelle fordommer fra systemet og leverer et objektivt resultat. Bias skjev bare resultatene dine og gjør det nytteløst.

3. Rengjør data grundig, da dette alltid vil øke kvaliteten på utdataene dine. Enhver dataforsker vil fortelle deg at en stor del av jobbrollen deres er å rense data. Når du renser dataene dine, fjerner du duplikater, støy, manglende verdier, strukturelle feil osv.

Hva påvirker kvaliteten på treningsdata?

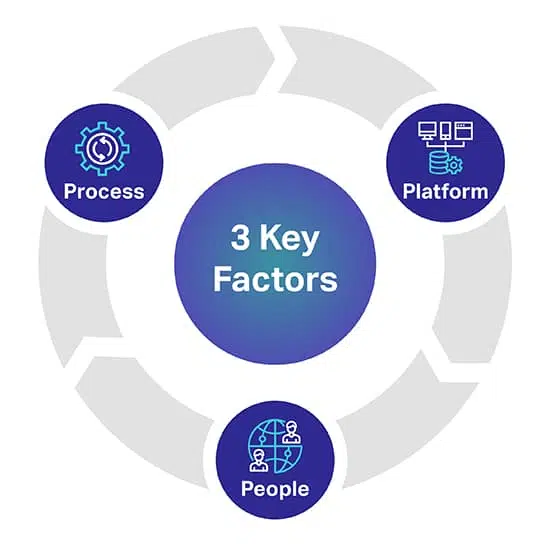

Det er tre hovedfaktorer som kan hjelpe deg å forutsi hvilket kvalitetsnivå du ønsker for AI/ML-modellene dine. De tre nøkkelfaktorene er mennesker, prosess og plattform som kan lage eller ødelegge AI-prosjektet ditt.

Plattform: En komplett proprietær plattform for mennesker er nødvendig for å kilde, transkribere og kommentere ulike datasett for å kunne implementere de mest krevende AI- og ML-initiativene. Plattformen er også ansvarlig for å administrere arbeidere, og maksimere kvalitet og gjennomstrømning

personer: For å få AI til å tenke smartere, kreves det folk som er noen av de smarteste hodene i bransjen. For å skalere trenger du tusenvis av disse fagpersonene over hele verden for å transkribere, merke og kommentere alle datatyper.

Prosess: Å levere gullstandarddata som er konsistente, fullstendige og nøyaktige er komplekst arbeid. Men det er det du alltid trenger å levere, for å overholde de høyeste kvalitetsstandardene samt strenge og velprøvde kvalitetskontroller og sjekkpunkter.

Hvor henter du AI Training Data fra?

I motsetning til vår forrige del, har vi en veldig presis innsikt her. For de av dere som ønsker å hente data

eller hvis du er i gang med videoinnsamling, bildesamling, tekstinnsamling med mer, er det tre

primære veier du kan hente dataene dine fra.

La oss utforske dem individuelt.

Gratis kilder

Gratis kilder er veier som er ufrivillige depoter for enorme mengder data. Det er data som rett og slett ligger der på overflaten gratis. Noen av de gratis ressursene inkluderer -

- Google-datasett, der over 250 millioner sett med data ble utgitt i 2020

- Fora som Reddit, Quora og mer, som er ressurssterke kilder for data. Dessuten kan datavitenskap og AI-miljøer i disse foraene også hjelpe deg med bestemte datasett når de blir kontaktet.

- Kaggle er en annen gratis kilde hvor du kan finne maskinlæringsressurser bortsett fra gratis datasett.

- Vi har også listet opp gratis åpne datasett for å komme i gang med å trene AI-modellene dine

Selv om disse veiene er gratis, er det du ville ende opp med å bruke tid og krefter. Data fra gratis kilder er overalt, og du må legge ned timevis med arbeid i innkjøp, rengjøring og skreddersydd for å passe dine behov.

En av de andre viktige tipsene å huske på er at noen av dataene fra gratiskilder også ikke kan brukes til kommersielle formål. Det krever datalisensiering.

Dataskraping

Som navnet antyder, er dataskraping prosessen med å utvinne data fra flere kilder ved å bruke passende verktøy. Fra nettsteder, offentlige portaler, profiler, journaler, dokumenter og mer, kan verktøy skrape data du trenger og få dem sømløst til databasen din.

Selv om dette høres ut som en ideell løsning, er dataskraping bare lovlig når det gjelder personlig bruk. Hvis du er et selskap som ønsker å skrape data med kommersielle ambisjoner involvert, blir det vanskelig og til og med ulovlig. Det er derfor du trenger et juridisk team for å se på nettsider, samsvar og betingelser før du kan skrape data du trenger.

Eksterne leverandører

Når det gjelder datainnsamling for AI-treningsdata, er outsourcing eller å nå ut til eksterne leverandører for datasett det mest ideelle alternativet. De tar ansvaret for å finne datasett for dine behov mens du kan fokusere på å bygge modulene dine. Dette er spesielt på grunn av følgende årsaker -

- du trenger ikke å bruke timer på å lete etter dataveier

- det er ingen innsats når det gjelder datarensing og klassifisering involvert

- du får i hånden kvalitetsdatasett som presist krysser av for alle faktorene vi diskuterte for en tid tilbake

- du kan få datasett som er skreddersydd for dine behov

- du kan kreve mengden data du trenger for prosjektet ditt og mer

- og det viktigste, de sikrer også at deres datainnsamling og selve dataene er i samsvar med lokale regulatoriske retningslinjer.

Den eneste faktoren som kan vise seg å være en mangel, avhengig av omfanget av operasjoner, er at outsourcing innebærer utgifter. Igjen, det som ikke innebærer utgifter.

Shaip er allerede ledende innen datainnsamlingstjenester og har sitt eget arkiv med helsedata og tale-/lyddatasett som kan lisensieres for dine ambisiøse AI-prosjekter.

Åpne datasett – Å bruke eller ikke bruke?

For eksempel er det Amazon-produktvurderingsdatasettet som inneholder over 142 millioner brukeranmeldelser fra 1996 til 2014. For bilder har du en utmerket ressurs som Google Open Images, hvor du kan hente datasett fra over 9 millioner bilder. Google har også en vinge kalt Machine Perception som tilbyr nærmere 2 millioner lydklipp som er på ti sekunders varighet.

Til tross for tilgjengeligheten av disse ressursene (og andre), er den viktige faktoren som ofte blir oversett forholdene som følger med bruken av dem. De er absolutt offentlige, men det er en tynn linje mellom brudd og rettferdig bruk. Hver ressurs kommer med sin egen tilstand, og hvis du utforsker disse alternativene, foreslår vi forsiktighet. Dette er fordi i påskudd av å foretrekke gratis veier, kan du ende opp med å pådra deg søksmål og beslektede utgifter.

De sanne kostnadene ved AI-treningsdata

Bare pengene du bruker på å skaffe data eller generere data internt er ikke det du bør vurdere. Vi må vurdere lineære elementer som tid og innsats brukt på å utvikle AI-systemer og koste fra et transaksjonsperspektiv. klarer ikke å komplimentere den andre.

Tid brukt på å skaffe og kommentere data

Faktorer som geografi, markedsdemografi og konkurranse innenfor din nisje hindrer tilgjengeligheten av relevante datasett. Tiden du bruker på å søke etter data manuelt, er å kaste bort tid på å trene opp AI-systemet ditt. Når du klarer å hente dataene dine, vil du forsinke treningen ytterligere ved å bruke tid på å kommentere dataene slik at maskinen din kan forstå hva den mates.

Prisen for å samle inn og kommentere data

Overheadutgifter (In-house datainnsamlere, annotatorer, vedlikehold av utstyr, teknisk infrastruktur, abonnement på SaaS-verktøy, utvikling av proprietære applikasjoner) må beregnes under innhenting av AI-data

Kostnaden for dårlige data

Dårlige data kan koste bedriftsteamets moral, konkurransefortrinn og andre håndgripelige konsekvenser som ikke blir lagt merke til. Vi definerer dårlige data som ethvert datasett som er urent, rått, irrelevant, utdatert, unøyaktig eller fullt av stavefeil. Dårlige data kan ødelegge AI-modellen din ved å introdusere skjevhet og ødelegge algoritmene dine med skjeve resultater.

Ledelsesutgifter

Alle kostnader som involverer administrasjonen av din organisasjon eller virksomhet, materielle og immaterielle eiendeler utgjør administrasjonsutgifter som ofte er de dyreste.

Hva skjer etter datakilden?

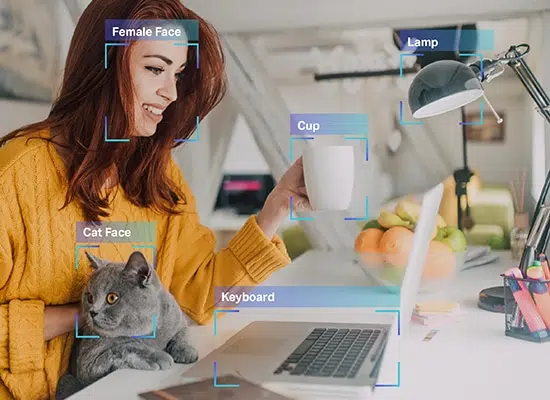

Når du har datasettet i hånden, er neste trinn å kommentere eller merke det. Etter alle de komplekse oppgavene er det rene rådata du har. Maskinen kan fortsatt ikke forstå dataene du har fordi de ikke er kommentert. Det er her den gjenværende delen av den virkelige utfordringen starter.

Som vi nevnte, trenger en maskin data i et format som den kan forstå. Dette er nøyaktig hva dataannotering gjør. Det krever rådata og legger til lag med etiketter og tagger for å hjelpe en modul med å forstå hvert enkelt element i dataene nøyaktig.

For eksempel, i en tekst, vil datamerking fortelle et AI-system den grammatiske syntaksen, deler av tale, preposisjoner, tegnsetting, følelser, følelser og andre parametere som er involvert i maskinforståelse. Dette er hvordan chatbots forstår menneskelige samtaler bedre, og bare når de gjør det kan de også etterligne menneskelige interaksjoner bedre gjennom svarene deres.

Så uunngåelig som det høres ut, er det også ekstremt tidkrevende og kjedelig. Uavhengig av omfanget av virksomheten din eller dens ambisjoner, er tiden det tar å kommentere data enorm.

Dette er først og fremst fordi den eksisterende arbeidsstyrken din trenger å dedikere tid til å kommentere data hvis du ikke har spesialister for datakommentarer. Så du må tilkalle teammedlemmene dine og tilordne dette som en tilleggsoppgave. Jo mer det blir forsinket, jo lengre tid tar det å trene AI-modellene dine.

Selv om det finnes gratisverktøy for datakommentarer, tar det ikke bort det faktum at denne prosessen er tidkrevende.

Det er her leverandører av datakommentarer som Shaip kommer inn. De tar med seg et dedikert team av datamerknadsspesialister for kun å fokusere på prosjektet ditt. De tilbyr deg løsninger på den måten du ønsker for dine behov og krav. Dessuten kan du sette en tidsramme med dem og kreve at arbeidet skal fullføres i den spesifikke tidslinjen.

En av de største fordelene er det faktum at dine interne teammedlemmer kan fortsette å fokusere på det som betyr mer for driften og prosjektet mens eksperter gjør jobben sin med å kommentere og merke data for deg.

Med outsourcing kan optimal kvalitet, minimal tid og maksimal presisjon sikres.

Innpakning Up

Det var alt om AI-treningsdata. Fra å forstå hva opplæringsdata er til å utforske gratis ressurser og fordeler med outsourcing av datakommentarer, vi diskuterte dem alle. Nok en gang er protokoller og retningslinjer fortsatt ustabile i dette spekteret, og vi anbefaler alltid at du tar kontakt med AI-treningsdataeksperter som oss for dine behov.

Fra innkjøp, avidentifikasjon til datakommentarer, vi vil hjelpe deg med alle dine behov, slik at du bare kan jobbe med å bygge plattformen din. Vi forstår vanskelighetene involvert i datainnhenting og merking. Derfor gjentar vi at du kan overlate de vanskelige oppgavene til oss og benytte deg av våre løsninger.

Ta kontakt med oss for alle dine behov for datakommentarer i dag.

La oss snakke

Ofte stilte spørsmål (FAQ)

Hvis du vil lage intelligente systemer, må du mate inn renset, kuratert og handlingsvennlig informasjon for å lette veiledet læring. Den merkede informasjonen kalles AI-treningsdata og omfatter markedsmetadata, ML-algoritmer og alt som hjelper med beslutningstaking.

Hver AI-drevet maskin har muligheter begrenset av sin historiske plass. Dette betyr at maskinen bare kan forutsi ønsket resultat hvis den har blitt trent tidligere med sammenlignbare datasett. Treningsdata hjelper med overvåket trening med volumet direkte proporsjonalt med effektiviteten og nøyaktigheten til AI-modellene.

Ulike opplæringsdatasett er nødvendig for å trene spesifikke maskinlæringsalgoritmer, for å hjelpe de AI-drevne oppsettene til å ta viktige avgjørelser med konteksten i tankene. Hvis du for eksempel planlegger å legge til Computer Vision-funksjonalitet til en maskin, må modellene trenes med kommenterte bilder og flere markedsdatasett. På samme måte, for NLP-dyktighet, fungerer store volumer av taleinnsamling som treningsdata.

Det er ingen øvre grense for mengden treningsdata som kreves for å trene en kompetent AI-modell. Større datavolumet bedre vil være modellens evne til å identifisere og segregere elementer, tekster og kontekster.

Selv om det er mye data tilgjengelig, er ikke hver del egnet for treningsmodeller. For at en algoritme skal fungere på sitt beste, trenger du omfattende, konsistente og relevante datasett, som er ensartet uttrukket, men likevel mangfoldig nok til å dekke et bredt spekter av scenarier. Uavhengig av dataene du planlegger å bruke, er det bedre å rense og kommentere det samme for forbedret læring.

Hvis du har en bestemt AI-modell i tankene, men treningsdataene ikke er helt nok, må du først fjerne uteliggere, koble sammen overførings- og iterative læringsoppsett, begrense funksjonalitet og gjøre oppsettet åpen kildekode for brukerne å fortsette å legge til data for trene maskinen, gradvis, i tide. Du kan til og med følge tilnærminger angående dataforstørrelse og overføringslæring for å få mest mulig ut av begrensede datasett.

Åpne datasett kan alltid brukes til å samle treningsdata. Men hvis du søker eksklusivitet for å trene modellene bedre, kan du stole på eksterne leverandører, gratis kilder som Reddit, Kaggle og mer, og til og med Data Scraping for selektivt mining av innsikt fra profiler, portaler og dokumenter. Uavhengig av tilnærmingen er det nødvendig å formatere, redusere og rense de anskaffede dataene før bruk.