Det første trinnet i å distribuere datasynsbaserte applikasjoner er å utvikle en datainnsamlingsstrategi. Data som er nøyaktige, dynamiske og i store mengder må settes sammen før ytterligere trinn, som merking og bildekommentar, kan gjennomføres. Selv om datainnsamling spiller en kritisk rolle i resultatet av datasynsapplikasjoner, blir det ofte oversett.

De datainnsamling av datasyn bør være slik at den er i stand til å fungere nøyaktig i en kompleks og dynamisk verden. Data som nøyaktig etterligner den skiftende naturverdenen bør brukes til å trene ML-systemer.

Før vi lærer om de må-ha-egenskapene i et datasett og utforsker de utprøvde metodene for datasettoppretting, la oss ta tak i hvorfor og når av to dominerende elementer i datainnsamling.

La oss begynne med "hvorfor".

Hvorfor er datainnsamling av god kvalitet viktig for å utvikle CV-søknader?

I følge en nylig publisert rapport, samle data har blitt en betydelig hindring for datasynsselskaper. Mangel på tilstrekkelig data (44 %) og dårlig datadekning (47 %) var noen av hovedårsakene til datarelaterte komplikasjoner. Dessuten, 57% av respondentene mente at noen av forsinkelsene i ML-opplæringen kunne vært lindret hvis datasettet inneholdt flere kantsaker.

Datainnsamling er et kritisk skritt i utviklingen av ML og CV-baserte verktøy. Det er en samling av tidligere hendelser som analyseres for å identifisere tilbakevendende mønstre. Ved å bruke disse mønstrene kan ML-systemene trenes til å utvikle svært nøyaktige prediktive modeller.

Prediktive CV-modeller er bare så gode som dataene du trener dem på. For en CV-søknad eller verktøy med høy ytelse, må du trene algoritmen på feilfri, mangfoldig, relevant, bilder av høy kvalitet.

Hvorfor er datainnsamling en kritisk og utfordrende oppgave?

Å samle inn store mengder verdifulle og kvalitetsdata for utvikling av datasynsapplikasjoner kan utgjøre en utfordring for både store og små bedrifter.

Så, hva gjør selskaper generelt? De går inn for datakilde for datasyn.

Mens åpen kildekode-datasett kan tjene dine umiddelbare behov, kan de også være fulle av unøyaktigheter, juridiske problemer og skjevheter. Det er ingen garanti for at datasettet vil være nyttig eller egnet for datasynsprosjekter. Noen ulemper ved å bruke åpen kildekode-datasett er som følger:

- Bilde- og videokvaliteten i datasettet gjør dataene ubrukelige.

- Datasettet kan mangle mangfold

- Datasettet kan fylles ut, men mangler nøyaktig merking og merknader, noe som resulterer i modeller med dårlig ytelse.

- Det kan være juridiske tvang som datasettet kan ignorere.

Her svarer vi på den andre delen av spørsmålet vårt – 'når

Når blir skreddersydd dataskaping den riktige strategien?

Når datainnsamlingsmetodene du bruker ikke gir de ønskede resultatene, må du vende deg til a tilpasset datainnsamling teknikk. Egendefinerte eller skreddersydde datasett er laget av den nøyaktige brukssaken din datasynsmodell trives med, siden de er tilpasset nøyaktig for AI-trening.

Med skreddersydd dataoppretting er det mulig å eliminere skjevheter og legge til dynamikk, kvalitet og tetthet til datasettene. I tillegg kan du også redegjøre for edge-tilfeller, noe som lar deg lage en modell som med hell imøtekommer kompleksiteten og uforutsigbarheten i den virkelige verden.

Grunnleggende om tilpasset datainnsamling

Nå vet vi at løsningen på dine datainnsamlingsbehov kan være å lage tilpassede datasett. Likevel kan det være en stor utfordring for de fleste bedrifter å samle inn enorme mengder bilder og videoer internt. Den neste løsningen ville være å outsource dataskapingen til premium datainnsamlingsleverandører.

- Kompetanse: En datainnsamlingsekspert har de spesialiserte verktøyene, teknikkene og utstyret for å lage bilder og videoer tilpasset prosjektkravene.

- Erfaring: Eksperter på dataoppretting og merknadstjenester skal kunne samle data tilpasset prosjektets behov.

- Simuleringer: Siden datainnsamling avhenger av frekvensen av hendelser som skal fanges opp, blir det en utfordring å målrette mot hendelser som forekommer sjelden eller i edge-case-scenarier.

For å dempe dette, simulerer eller skaper erfarne bedrifter opplæringsscenarier. Disse realistisk simulerte bildene bidrar til å forsterke datasettet ved å konstruere miljøer som er vanskelige å finne. - Samsvar: Når datasettsamlingen er outsourcet til pålitelige leverandører, er det lettere å sikre overholdelse av lovoverholdelse og beste praksis.

Evaluering av kvaliteten på opplæringsdatasett

Mens vi har etablert det vesentlige av et ideelt datasett, la oss nå snakke om å evaluere kvalitetene til datasett.

Datatilstrekkelighet: Jo større antall merkede forekomster datasettet ditt har, desto bedre er modellen.

Det finnes ikke noe sikkert svar på mengden data du måtte trenge for prosjektet ditt. Datamengden avhenger imidlertid av typen og funksjonene som finnes i modellen din. Start datainnsamlingsprosessen sakte, og øk mengden avhengig av modellens kompleksitet.

Datavariabilitet: I tillegg til kvantitet er datavariabilitet også viktig å ta hensyn til når man skal bestemme datasettets kvalitet. Å ha flere variabler vil oppheve dataubalanse og hjelpe til med å tilføre verdi til algoritmen.

Datamangfold: En dyp læringsmodell trives med datamangfold og dynamikk. For å sikre at modellen ikke er partisk eller inkonsekvent, unngå over- eller underrepresentasjon av scenarier.

Anta for eksempel at en modell blir opplært til å identifisere bilder av biler, og at modellen kun har blitt trent på bilbilder tatt i dagslys. I så fall vil den gi unøyaktige spådommer når den eksponeres i løpet av natten.

Datapålitelighet: Pålitelighet og nøyaktighet avhenger av flere faktorer, for eksempel menneskelige feil på grunn av manuelle datamerking, duplisering av data og unøyaktige datamerkingsattributter.

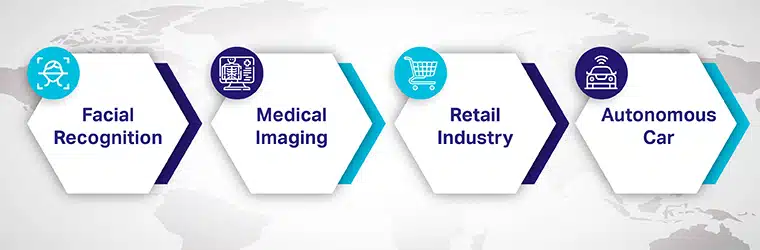

Brukstilfeller av datasyn

Kjernekonseptene for datasyn er integrert med maskinlæring for å levere hverdagsapplikasjoner og avanserte produkter. Noen av de vanligste datasynsapplikasjoner er

Ansiktsgjenkjenning: Ansiktsgjenkjenningsapplikasjoner er et veldig vanlig eksempel på datasyn. Bruk av sosiale medier-applikasjoner ansiktsgjenkjenning for å identifisere og merke brukere på bilder. CV-algoritmen matcher ansiktet i bilder til ansiktsprofildatabasen.

Medisinsk bildebehandling: Medisinsk bildebehandling data for datasyn spiller en viktig rolle i levering av helsetjenester ved å automatisere kritiske oppgaver som å oppdage svulster eller krefthudlesjoner.

Detaljhandel og e-handelsbransjen: Netthandelsindustrien finner også datasynsteknologi nyttig. De bruker en algoritme som identifiserer klesplagg og klassifiserer dem enkelt. Dette bidrar til å forbedre søk og anbefalinger for en bedre brukeropplevelse.

Autonome biler: Datasyn baner vei for avansert autonome kjøretøyer ved å forbedre deres evner til å forstå omgivelsene. CV-programvaren mates med tusenvis av videoopptak fra forskjellige vinkler. De blir behandlet og analysert for å forstå veiskilt og oppdage andre kjøretøy, fotgjengere, gjenstander og andre kant-case-scenarier.

Så, hva er det første trinnet i å utvikle en avansert, effektiv og pålitelig datasynsløsning opplært på ML-modeller?

Oppsøker eksperter på datainnsamling og merknader som kan gi den høyeste kvaliteten AI-treningsdata for datasyn med ekspert-annotatorer for å sikre nøyaktighet.

Med et stort, mangfoldig datasett av høy kvalitet kan du fokusere på opplæring, innstilling, utforming og distribusjon av den neste store datasynsløsningen. Og ideelt sett bør datatjenestepartneren din være Shaip, bransjelederen i å tilby ende-til-ende-testede datasynstjenester for utvikling av AI-applikasjoner i den virkelige verden.

[Les også: AI Training Data Starter Guide: Definisjon, Eksempel, Datasett]