En nybegynnerveiledning for AI-datainnsamling

Velge AI Data Collection Company for ditt AI / ML-prosjekt

Introduksjon

Per nå tråkker vi på rett vei med betydelige gjennombrudd på tvers av bransjer ved hjelp av AI. Hvis du for eksempel tar helsetjenester, hjelper AI-systemer ledsaget av maskinlæringsmodeller eksperter til å forstå kreft bedre og komme opp med behandlinger for den. Nevrologiske lidelser og bekymringer som PTSD blir behandlet ved hjelp av AI. Vaksiner utvikles i raske takter takket være AI-drevne kliniske studier og simuleringer.

Ikke bare helsevesenet, hver eneste bransje eller segment som AI berører blir revolusjonert. Autonome kjøretøy, smarte nærbutikker, wearables som FitBit og til og med smarttelefonkameraene våre er i stand til å ta bedre bilder av ansiktene våre med AI.

Takket være innovasjonene som skjer i AI-området, kommer bedrifter inn i spekteret med ulike brukstilfeller og løsninger. På grunn av dette forventes det globale AI-markedet å nå en markedsverdi på rundt 267 milliarder dollar innen utgangen av 2027. Dessuten implementerer rundt 37 % av virksomhetene der ute AI-løsninger i sine prosesser og produkter.

Mer interessant er det at nesten 77 % av produktene og tjenestene vi bruker i dag er drevet av AI. Med teknologikonseptet som øker betydelig på tvers av vertikaler, hvordan klarer bedrifter å gjøre det umulig med AI?

Hvordan får chatboter oss til å tro at vi snakker med et annet menneske på den andre siden?

Hvis du observerer svaret på hvert spørsmål, koker det ned til bare ett element – DATA. Data ligger i sentrum av alle AI-spesifikke operasjoner og prosesser. Det er data som hjelper maskiner å forstå konsepter, prosessinnganger og levere nøyaktige resultater.

Alle de store AI-løsningene som finnes der ute, er alle produkter av en avgjørende prosess vi kaller datainnsamling eller datainnsamling eller AI-treningsdata.

Denne omfattende veiledningen handler om å hjelpe deg å forstå hva det er og hvorfor det er viktig.

Hva er AI-datainnsamling?

Maskiner har ikke et eget sinn. Fraværet av dette abstrakte konseptet gjør dem blottet for meninger, fakta og evner som resonnement, erkjennelse og mer. De er bare faste bokser eller enheter som opptar plass. For å gjøre dem om til kraftige medier trenger du algoritmer og enda viktigere data.

Hvert eneste AI-aktiverte produkt eller løsning vi bruker i dag og resultatene de tilbyr stammer fra år med opplæring, utvikling og optimalisering. Fra enheter som tilbyr navigasjonsruter til de komplekse systemene som forutsier utstyrsfeil dager i forveien, har hver enkelt enhet gått gjennom år med AI-trening for å kunne levere nøyaktige resultater.

AI-datainnsamling er det foreløpige trinnet i prosessen med AI-utvikling som helt fra begynnelsen bestemmer hvor effektivt og effektivt et AI-system vil være. Det er prosessen med å hente inn relevante datasett fra en myriade av kilder som vil hjelpe AI-modeller med å behandle detaljer bedre og gi meningsfulle resultater.

Typer AI-treningsdata i maskinlæring

Nå er AI-datainnsamling et paraplybegrep. Data i dette rommet kan bety hva som helst. Det kan være tekst, videoopptak, bilder, lyd eller en blanding av alle disse. Kort sagt, alt som er nyttig for en maskin for å utføre sin oppgave med å lære og optimalisere resultater, er data. For å gi deg mer innsikt i de forskjellige datatypene, her er en rask liste:

Datasett kan være fra en strukturert eller ustrukturert kilde. For de uinnvidde er strukturerte datasett de som har eksplisitt betydning og format. De er lett forståelige av maskiner. Ustrukturert, derimot, er detaljer i datasett som er over alt. De følger ikke en bestemt struktur eller format og krever menneskelig inngripen for å hente ut verdifull innsikt fra slike datasett.

Tekstdata

En av de mest tallrike og fremtredende formene for data. Tekstdata kan struktureres i form av innsikt fra databaser, GPS-navigasjonsenheter, regneark, medisinsk utstyr, skjemaer og mer. Ustrukturert tekst kan være undersøkelser, håndskrevne dokumenter, bilder av tekst, e-postsvar, kommentarer på sosiale medier og mer.

Lyddata

Lyddatasett hjelper bedrifter med å utvikle bedre chatbots og systemer, designe bedre virtuelle assistenter og mer. De hjelper også maskiner med å forstå aksenter og uttaler til de forskjellige måtene et enkelt spørsmål eller spørring kan stilles på.

Bildedata

Bilder er en annen fremtredende datasetttype som brukes til forskjellige formål. Fra selvkjørende biler og applikasjoner som Google Lens til ansiktsgjenkjenning, bilder hjelper systemer med å finne sømløse løsninger.

Videodata

Videoer er mer detaljerte datasett som lar maskiner forstå noe i dybden. Videodatasett er hentet fra datasyn, digital bildebehandling og mer.

Hvordan samle inn data for en maskinlæring?

Så hvordan henter du dataene dine? Hvilke data trenger du og hvor mye av dem? Hva er de mange kildene for å hente relevante data?

Bedrifter vurderer nisjen og formålet med ML-modellene deres og kartlegger potensielle måter å hente relevante datasett på. Å definere datatypen som trengs løser en stor del av bekymringen din om datainnhenting. For å gi deg en bedre ide finnes det forskjellige kanaler, veier, kilder eller medier for datainnsamling:

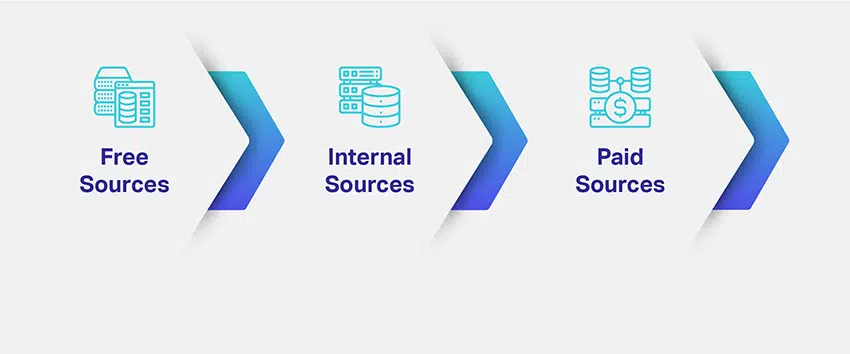

Gratis kilder

Som navnet antyder, er dette ressurser som tilbyr datasett for AI-opplæringsformål gratis. Gratis kilder kan være alt fra offentlige fora, søkemotorer, databaser og kataloger til offentlige portaler som vedlikeholder arkiver med informasjon gjennom årene.

Hvis du ikke vil legge for mye krefter på å skaffe gratis datasett, finnes det dedikerte nettsteder og portaler som Kaggle, AWS-ressurs, UCI-database og mer som lar deg utforske forskjellige

kategorier og last ned nødvendige datasett gratis.

Interne ressurser

Selv om gratis ressurser ser ut til å være praktiske alternativer, er det flere begrensninger knyttet til dem. For det første kan du ikke alltid være sikker på at du finner datasett som nøyaktig samsvarer med dine behov. Selv om de samsvarer, kan datasett være irrelevante når det gjelder tidslinjer.

Hvis markedssegmentet ditt er relativt nytt eller uutforsket, vil det ikke være mange kategorier eller relevante

datasett som du også kan laste ned. For å unngå de foreløpige manglene med gratis ressurser, der

finnes en annen dataressurs som fungerer som en kanal for deg for å generere mer relevante og kontekstuelle datasett.

De er dine interne kilder som CRM-databaser, skjemaer, e-postmarkedsføringsemner, produkt- eller tjenestedefinerte kontaktpunkter, brukerdata, data fra bærbare enheter, nettsidedata, varmekart, innsikt i sosiale medier og mer. Disse interne ressursene er definert, satt opp og vedlikeholdt av deg. Så du kan være sikker på dens troverdighet, relevans og nylig.

Betalte ressurser

Uansett hvor nyttige de høres ut, har interne ressurser også sin del av komplikasjoner og begrensninger. For eksempel vil mesteparten av fokuset til talentmassen din gå til å optimalisere datakontaktpunkter. Dessuten må koordineringen mellom teamene og ressursene dine også være upåklagelig.

For å unngå flere slike hikke som disse, har du betalte kilder. De er tjenester som tilbyr deg de mest nyttige og kontekstuelle datasettene for prosjektene dine og sikrer at du konsekvent får dem når du trenger det.

Det første inntrykket de fleste av oss har på betalte kilder eller dataleverandører er at de er dyre. Derimot,

når du regner, er de bare billige i det lange løp. Takket være deres ekspansive nettverk og datakildemetoder, vil du kunne motta komplekse datasett for AI-prosjektene dine uavhengig av hvor usannsynlige de er.

For å gi deg en detaljert oversikt over forskjellene mellom de tre kildene, her er en forseggjort tabell:

| Gratis Ressurser | Interne ressurser | Betalte ressurser |

|---|---|---|

| Datasett er tilgjengelig gratis. | Interne ressurser kan også være gratis avhengig av driftsutgiftene dine. | Du betaler en dataleverandør for å hente relevante datasett for deg. |

| Flere gratis ressurser tilgjengelig på nettet for å laste ned foretrukne datasett. | Du får spesialdefinerte data i henhold til dine behov for AI-trening. | Du får egendefinerte data konsekvent så lenge du trenger det. |

| Du må jobbe manuelt med å kompilere, kuratere, formatere og kommentere datasett. | Du kan til og med endre datakontaktpunktene dine for å generere datasett med nødvendig informasjon. | Datasett fra leverandører er klargjort for maskinlæring. Det betyr at de er kommentert og kommer med kvalitetssikring. |

| Vær forsiktig med lisensierings- og overholdelsesbegrensninger på datasett du laster ned. | Interne ressurser blir risikable hvis du har begrenset tid til å markedsføre produktet ditt. | Du kan definere tidsfrister og få datasett levert deretter. |

Hvordan påvirker dårlige data AI-ambisjonene dine?

Vi har listet opp de tre vanligste dataressursene av den grunn at du vil ha en ide om hvordan du kan nærme deg datainnsamling og innhenting. Men på dette tidspunktet blir det viktig å også forstå at avgjørelsen din alltid kan avgjøre skjebnen til AI-løsningen din.

I likhet med hvordan høykvalitets AI-treningsdata kan hjelpe modellen din til å levere nøyaktige og rettidige resultater, kan dårlige treningsdata også bryte AI-modellene dine, forvride resultater, introdusere skjevheter og gi andre uønskede konsekvenser.

Men hvorfor skjer dette? Er det ikke meningen at noen data skal trene og optimalisere AI-modellen din? Ærlig talt, nei. La oss forstå dette nærmere.

Dårlige data – hva er det?

Forskjellen mellom ustrukturerte og dårlige data er at innsikt i ustrukturerte data er over alt. Men i hovedsak kan de være nyttige uansett. Ved å bruke ekstra tid vil dataforskere fortsatt kunne trekke ut relevant informasjon fra ustrukturerte datasett. Det er imidlertid ikke tilfelle med dårlige data. Disse datasettene inneholder ingen/begrenset innsikt eller informasjon som er verdifull eller relevant for AI-prosjektet ditt eller dets opplæringsformål.

Så når du henter datasettene dine fra gratis ressurser eller har løst etablerte interne datakontaktpunkter, er sjansen stor for at du vil laste ned eller generere dårlige data. Når forskerne jobber med dårlige data, kaster du ikke bare bort menneskelige timer, men presser også på lanseringen av produktet ditt.

Hvis du fortsatt er usikker på hva dårlige data kan gjøre med ambisjonene dine, her er en rask liste:

- Du bruker utallige timer på å skaffe de dårlige dataene og kaster bort timer, krefter og penger på ressurser.

- Dårlige data kan føre til juridiske problemer, hvis de ikke blir lagt merke til, og kan redusere effektiviteten til AI-en din

modeller. - Når du tar produktet trent på dårlige data live, påvirker det brukeropplevelsen

- Dårlige data kan gjøre resultater og slutninger partiske, noe som kan gi ytterligere tilbakeslag.

Så hvis du lurer på om det finnes en løsning på dette, er det faktisk det.

AI Training Dataleverandører til unnsetning

Alt du trenger å gjøre er å ta inn dataene og trene AI-modellene dine for perfeksjon. Når det er sagt, er vi sikre på at ditt neste spørsmål handler om utgiftene forbundet med å samarbeide med dataleverandører. Vi forstår at noen av dere allerede jobber med et mentalt budsjett, og det er akkurat dit vi er på vei videre.

Faktorer du bør vurdere når du skal lage et effektivt budsjett for datainnsamlingsprosjektet ditt

AI-trening er en systematisk tilnærming, og det er derfor budsjettering blir en integrert del av det. Faktorer som avkastning, nøyaktighet av resultater, opplæringsmetoder og mer bør vurderes før du investerer en enorm sum penger i AI-utvikling. Mange prosjektledere eller bedriftseiere famler på dette stadiet. De tar forhastede beslutninger som fører til irreversible endringer i produktutviklingsprosessen, og til slutt tvinger dem til å bruke mer.

Imidlertid vil denne delen gi deg den rette innsikten. Når du setter deg ned for å jobbe med budsjettet for AI-trening, er tre ting eller faktorer uunngåelige.

La oss se på hver enkelt i detalj.

Mengden data du trenger

Vi har hele tiden sagt at effektiviteten og nøyaktigheten til AI-modellen din avhenger av hvor mye den er trent. Dette betyr at jo mer volumet av datasett, jo mer læring. Men dette er veldig vagt. For å sette et tall på denne oppfatningen publiserte Dimensional Research en rapport som avslørte at bedrifter trenger minimum 100,000 XNUMX prøvedatasett for å trene AI-modellene sine.

Med 100,000 100,000 datasett mener vi XNUMX XNUMX kvalitets- og relevante datasett. Disse datasettene bør ha alle de essensielle egenskapene, merknadene og innsiktene som kreves for at algoritmene og maskinlæringsmodellene dine skal kunne behandle informasjon og utføre tiltenkte oppgaver.

Med dette er en generell tommelfingerregel, la oss forstå at mengden av data du trenger også avhenger av en annen intrikat faktor som er din bedrifts brukssituasjon. Hva du har tenkt å gjøre med produktet eller løsningen avgjør også hvor mye data du trenger. For eksempel vil en bedrift som bygger en anbefalingsmotor ha andre datavolumkrav enn et selskap som bygger en chatbot.

Dataprisstrategi

Når du er ferdig med å fullføre hvor mye data du faktisk trenger, må du jobbe videre med en dataprisstrategi. Dette betyr på en enkel måte hvordan du vil betale for datasettene du anskaffer eller genererer.

Generelt er dette de konvensjonelle prisstrategiene som følges i markedet:

| Data-type | Pris strategi |

|---|---|

| Pris per enkelt bildefil | |

| Pris per sekund, minutt, time eller enkeltbilde | |

| Pris per sekund, et minutt eller time | |

| Pris per ord eller setning |

Men vent. Dette er igjen en tommelfingerregel. De faktiske kostnadene ved å anskaffe datasett avhenger også av faktorer som:

- Det unike markedssegmentet, demografi eller geografi der datasett må hentes fra

- Det kompliserte i brukssaken din

- Hvor mye data trenger du?

- Din tid til å markedsføre

- Eventuelle skreddersydde krav og mer

Hvis du observerer, vil du vite at kostnadene for å skaffe bulkmengder med bilder for AI-prosjektet ditt kan være mindre, men hvis du har for mange spesifikasjoner, kan prisene skyte opp.

Dine kildestrategier

Dette er vanskelig. Som du så, er det forskjellige måter å generere eller hente data for AI-modellene dine på. Sunn fornuft vil tilsi at gratis ressurser er de beste siden du kan laste ned nødvendige mengder datasett gratis uten noen komplikasjoner.

Akkurat nå ser det også ut til at betalte kilder er for dyre. Men det er her et lag med komplikasjoner blir lagt til. Når du henter datasett fra gratisressurser, bruker du ekstra tid og krefter på å rense datasettene dine, kompilere dem til ditt forretningsspesifikke format og deretter kommentere dem individuelt. Du pådrar deg driftskostnader i prosessen.

Med betalte kilder er betalingen engangsbetaling og du får også maskinklare datasett i hånden på det tidspunktet du trenger. Kostnadseffektiviteten er veldig subjektiv her. Hvis du føler at du har råd til å bruke tid på å kommentere gratis datasett, kan du budsjettere deretter. Og hvis du tror at konkurransen din er hard og med begrenset tid til å markedsføre, kan du skape en ringvirkning i markedet, du bør foretrekke betalte kilder.

Budsjettering handler om å bryte ned detaljene og tydelig definere hvert fragment. Disse tre faktorene bør tjene deg som et veikart for budsjetteringsprosessen for AI-trening i fremtiden.

Sparer du på utgifter med intern datainnsamling?

Vi vet at du fortsatt er nølende til betalte kilder, og det er derfor denne delen vil fjerne skepsisen din til det og kaste lys over de skjulte kostnadene forbundet med intern datagenerering.

Er intern datainnsamling dyrt?

Ja, det er det!

Nå, her er et forseggjort svar. Utgifter er alt du bruker. Mens vi diskuterte gratis ressurser, avslørte vi at du bruker penger, tid og krefter på prosessen. Dette gjelder også for intern datainnsamling.

Til syvende og sist vil du ende opp med å bruke penger på å betale dine ansatte, dataforskere, annotatorer, kvalitetssikringseksperter og mer. Du vil også bruke på abonnementer for merknadsverktøy og

vedlikehold av CMS, CRM og andre infrastrukturutgifter.

Dessuten er datasett nødt til å ha skjevheter og nøyaktighetsproblemer, som du trenger for å sortere dem manuelt. Og hvis du har et slitasjeproblem i AI-treningsdatateamet ditt, må du bruke penger på å rekruttere nye medlemmer, orientere dem om prosessene dine, trene dem til å bruke verktøyene dine og mer.

Du vil ende opp med å bruke mer enn hva du til slutt ville tjene på lengre sikt. Det er også anmerkningsutgifter. På et gitt tidspunkt er den totale kostnaden som påløper for å arbeide med interne data:

Påløpte kostnader = Antall kommentatorer * Kostnad per kommentator + plattformkostnad

Hvis AI-treningskalenderen din er planlagt for måneder, forestill deg utgiftene du konsekvent vil pådra deg. Så, er dette den ideelle løsningen for datainnsamlingsproblemer, eller er det noe alternativ?

Fordeler med en ende-til-ende AI Data Collection-tjenesteleverandør

Det er en pålitelig løsning på dette problemet, og det er bedre og rimeligere måter å skaffe treningsdata for AI-modellene dine på. Vi kaller dem opplæringsdatatjenesteleverandører eller dataleverandører.

De er virksomheter som Shaip som spesialiserer seg på å levere datasett av høy kvalitet basert på dine unike behov og krav. De tar bort alle problemene du møter i datainnsamlingen som å hente inn relevante datasett, rense, kompilere og kommentere dem og mer, og lar deg fokusere kun på å optimalisere AI-modellene og algoritmene dine. Ved å samarbeide med dataleverandører fokuserer du på ting som betyr noe og på dem du har kontroll over.

Dessuten vil du også eliminere alle problemene forbundet med å hente datasett fra gratis og interne ressurser. For å gi deg en bedre forståelse av fordelene med en ende-til-ende dataleverandør, her er en rask liste:

- Leverandører av opplæringsdatatjenester forstår helt markedssegmentet ditt, brukertilfeller, demografi og andre detaljer for å hente de mest relevante dataene for AI-modellen din.

- De har muligheten til å hente ulike datasett som finner passende for prosjektet ditt, for eksempel bilder, videoer, tekst, lydfiler eller alle disse.

- Dataleverandører renser data, strukturerer dem og merker dem med attributter og innsikt som maskiner og algoritmer krever for å lære og behandle. Dette er en manuell innsats som krever grundig oppmerksomhet på detaljer og tid.

- Du har fageksperter som tar seg av å kommentere viktig informasjon. Hvis for eksempel produktet ditt er i helsevesenet, kan du ikke få det kommentert fra en ikke-helsepersonell og forvente nøyaktige resultater. Med dataleverandører er det ikke tilfelle. De jobber med små og mellomstore bedrifter og sørger for at de digitale bildedataene dine er riktig kommentert av bransjeveteraner.

- De tar seg også av dataavidentifikasjon og overholder HIPAA eller andre bransjespesifikke samsvar og protokoller, slik at du holder deg unna alle former for juridiske komplikasjoner.

- Dataleverandører jobber utrettelig med å eliminere skjevheter fra datasettene deres, og sikrer at du har objektive resultater og slutninger.

- Du vil også motta de nyeste datasettene i din nisje slik at AI-modellene dine er optimalisert for optimal effektivitet.

- De er også enkle å jobbe med. For eksempel kan plutselige endringer i datakrav kommuniseres til dem, og de vil sømløst hente passende data basert på oppdaterte behov.

Med disse faktorene er vi overbevist om at du nå forstår hvor kostnadseffektivt og enkelt samarbeid med leverandører av opplæringsdata er. Med denne forståelsen, la oss finne ut hvordan du kan velge den mest ideelle dataleverandøren for AI-prosjektet ditt.

Innhenting av relevante datasett

Forstå markedet, brukstilfeller, demografi for å hente nyere datasett, enten det er bilder, videoer, tekst eller lyd.

Rengjør relevante data

Strukturer og merk dataene med attributter og innsikt som maskiner og algoritmer forstår.

Databias

Eliminer skjevheter fra datasett, og sørg for at du har objektive resultater og slutninger.

Datanotering

Fageksperter fra spesifikke domener tar seg av å kommentere viktig informasjon.

Avidentifisering av data

Overhold HIPAA, GDPR eller andre bransjespesifikke samsvar og protokoller for å eliminere juridisk kompleksitet.

Hvordan velge riktig AI Data Collection Company

Å velge et AI-datainnsamlingsselskap er ikke så komplisert eller tidkrevende som å samle inn data fra gratis ressurser. Det er bare noen få enkle faktorer du trenger å vurdere og deretter håndhilse for et samarbeid.

Når du begynner å lete etter en dataleverandør, antar vi at du har fulgt og vurdert det vi har diskutert så langt. Men her er en rask oppsummering:

- Du har en veldefinert brukssak i tankene

- Ditt markedssegment og datakrav er tydelig etablert

- Budsjettet ditt er på punkt

- Og du har en ide om mengden data du trenger

Med disse elementene merket av, la oss forstå hvordan du kan se etter en ideell leverandør av treningsdatatjenester.

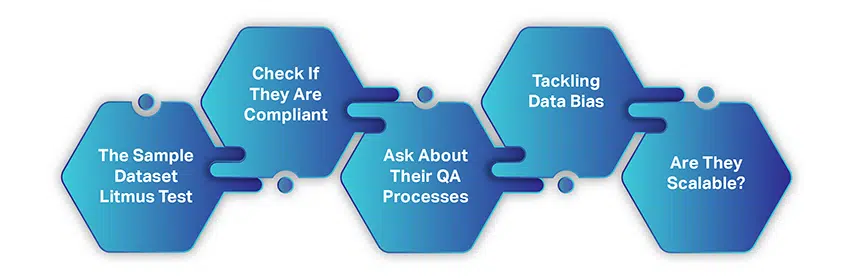

Sample Dataset Lakmustest

Før du signerer en langsiktig avtale, er det alltid en god idé å forstå en dataleverandør i detalj. Så start samarbeidet med et krav om et eksempeldatasett som du betaler for.

Dette kan være et lite datasett for å vurdere om de har forstått kravene dine, har de riktige innkjøpsstrategiene på plass, samarbeidsprosedyrene deres, åpenhet og mer. Tatt i betraktning det faktum at du vil være i kontakt med flere leverandører på dette tidspunktet, vil dette hjelpe deg å spare tid på å bestemme deg for en leverandør og endelig finne ut hvem som til slutt passer best for dine behov.

Sjekk om de er kompatible

Som standard overholder de fleste leverandører av opplæringsdatatjenester alle regulatoriske krav og protokoller. Men for å være på den sikre siden kan du spørre om deres overholdelse og retningslinjer og deretter begrense valget ditt.

Spør om deres QA-prosesser

Selve prosessen med datainnsamling er systematisk og lagdelt. Det er en lineær metodikk som er implementert. For å få en ide om hvordan de fungerer, spør om QA-prosessene deres og spør om datasettene de henter inn og kommenterer blir bestått gjennom kvalitetssjekker og revisjoner. Dette vil gi deg en

idé om hvorvidt de endelige leveransene du vil motta er maskinklare.

Håndtere databias

Bare en informert kunde ville spørre om skjevheter i opplæringsdatasett. Når du snakker med opplæringsdataleverandører, snakk om databias og hvordan de klarer å eliminere skjevheter i datasettene de genererer eller anskaffer. Selv om det er sunn fornuft at det er vanskelig å eliminere skjevhet helt, kan du fortsatt kjenne til de beste fremgangsmåtene de følger for å holde skjevheten i sjakk.

Er de skalerbare?

Engangsleveranser er bra. Langsiktige leveranser er bedre. De beste samarbeidene er imidlertid de som støtter forretningsvisjonene dine og som samtidig skalerer leveransene deres med økende

krav.

Så diskuter om leverandørene du snakker med kan skalere opp når det gjelder datavolum hvis et behov oppstår. Og hvis de kan, hvordan vil prisstrategien endres tilsvarende.

konklusjonen

Vil du vite en snarvei for å finne den beste leverandøren av AI-treningsdata? Ta kontakt med oss. Hopp over alle disse kjedelige prosessene og samarbeid med oss for de mest høykvalitets og presise datasettene for AI-modellene dine.

Vi krysser av for alle boksene vi har diskutert så langt. Etter å ha vært en pioner på dette området, vet vi hva som kreves for å bygge og skalere en AI-modell og hvordan data er i sentrum av alt.

Vi mener også at Kjøperveiledningen var omfattende og ressurssterk på forskjellige måter. AI-trening er komplisert som det er, men med disse forslagene og anbefalingene kan du gjøre dem mindre kjedelige. Til slutt er produktet ditt det eneste elementet som til slutt vil dra nytte av alt dette.

Er du ikke enig?