I en verden der forretningsbedrifter kjemper mot hverandre for å være de første til å transformere sin forretningspraksis ved å bruke kunstig intelligens-løsninger, ser datamerking ut til å være den eneste oppgaven alle begynner å snuble på. Kanskje det er fordi kvaliteten på dataene du trener AI-modellene dine på, bestemmer nøyaktigheten og suksessen.

Datamerking eller datamerking er aldri en engangshendelse. Det er en kontinuerlig prosess. Det er ikke noe sentralt punkt der du kanskje tror at du har trent nok eller at AI-modellene dine er nøyaktige når det gjelder å oppnå resultater.

Men hvor går AIs løfte om å utnytte nye muligheter galt? Noen ganger under datamerkingsprosessen.

Et av de største smertepunktene for virksomheter som inkorporerer AI-løsninger er datakommentarer. Så la oss ta en titt på de 5 beste datamerkingsfeilene du bør unngå.

Topp 5 datamerkingsfeil å unngå

Samler ikke nok data for prosjektet

Data er avgjørende, men de bør være relevante for prosjektmålene dine. For at modellen skal gi nøyaktige resultater, bør dataene den er trent på merkes, kvalitetssjekkes for å sikre nøyaktighet.

Hvis du vil utvikle en fungerende, pålitelig AI-løsning, må du mate den med store mengder relevante data av høy kvalitet. Og du må hele tiden mate disse dataene til maskinlæringsmodellene dine slik at de kan forstå og korrelere ulike deler av informasjonen du gir.

Tydeligvis, jo større datasett du bruker, jo bedre vil spådommene være.

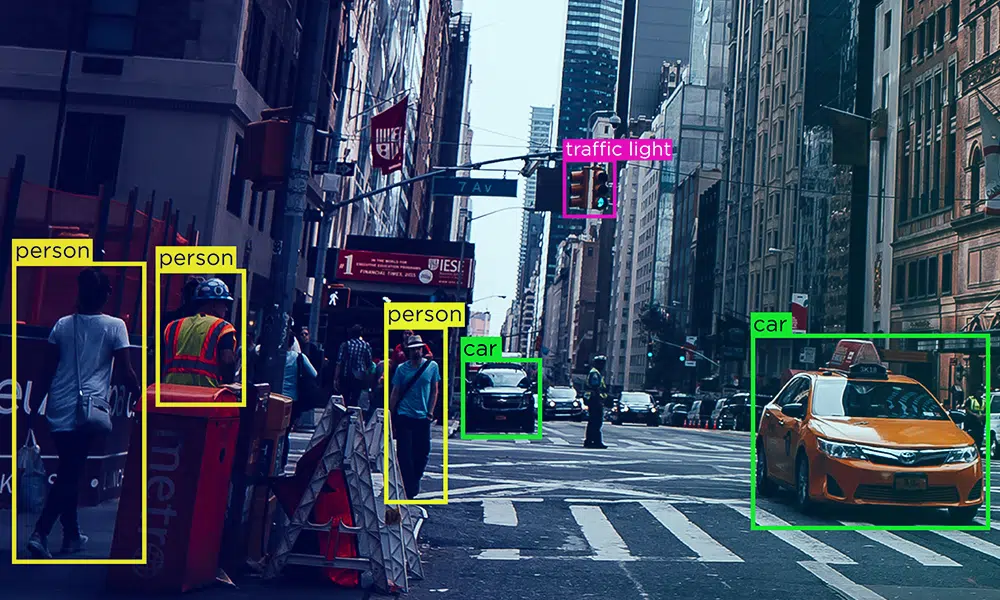

En fallgruve i datamerkingsprosessen er å samle svært lite data for mindre vanlige variabler. Når du merker bilder basert på en vanlig tilgjengelig variabel i rådokumentene, trener du ikke dyplærings-AI-modellen din på andre mindre vanlige variabler.

Dyplæringsmodeller krever tusenvis av databiter for at modellen skal fungere rimelig godt. For eksempel, når du trener en AI-basert robotarm til å manøvrere komplekst maskineri, kan hver liten variasjon i jobben kreve en annen gruppe med treningsdatasett. Men å samle slike data kan være dyrt og noen ganger rett og slett umulig, og vanskelig å kommentere for enhver bedrift.

Validerer ikke datakvalitet

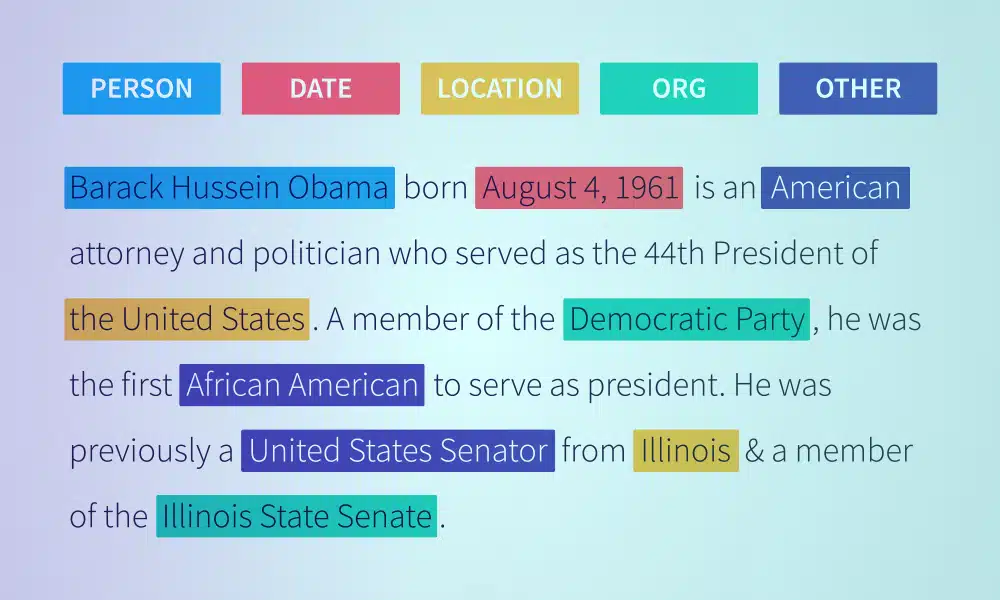

Selv om det er én ting å ha data, er det også viktig å validere datasettene du bruker for å sikre at de holder høy kvalitet. Imidlertid synes bedrifter det er utfordrende å skaffe kvalitetsdatasett. Generelt er det to grunnleggende typer datasett - subjektive og objektive.

Når du merker datasett, kommer etikettørens subjektive sannhet inn. For eksempel kan deres erfaring, språk, kulturelle tolkninger, geografi og mer påvirke deres tolkning av data. Hver merker vil alltid gi et annet svar basert på sine egne skjevheter. Men subjektive data har ikke et "riktig eller galt svar - det er derfor arbeidsstyrken må ha klare standarder og retningslinjer når de merker bilder og andre data.

Utfordringen ved objektive data er risikoen for at merkemaskinen ikke har domeneerfaring eller kunnskap til å identifisere de riktige svarene. Det er umulig å gjøre helt unna menneskelige feil, så det blir viktig å ha standarder og en lukket tilbakemeldingsmetode.

Ikke fokus på arbeidsstyrkeledelse

Maskinlæringsmodeller er avhengige av store datasett av forskjellige typer, slik at hvert scenario blir tatt hensyn til. Vellykkede bildekommentarer kommer imidlertid med sitt eget sett med utfordringer for arbeidsstyrkestyring.

Et stort problem er å administrere en enorm arbeidsstyrke som manuelt kan behandle betydelige ustrukturerte datasett. Det neste er å opprettholde høykvalitetsstandarder på tvers av arbeidsstyrken. Mange problemer kan beskjæres under datakommentarprosjekter.

Noen er:

- Behovet for å lære opp nye merkevare i bruk av merknadsverktøy

- Dokumentere instruksjoner i kodeboken

- Sørge for at kodeboken følges av alle teammedlemmene

- Definere arbeidsflyten – tildele hvem som gjør hva basert på deres evner

- Krysssjekke og løse tekniske problemer

- Sikre kvalitet og validering av datasett

- Sørger for jevnt samarbeid mellom etiketteringsteam

- Minimerer etikettskjevhet

For å være sikker på at du seiler gjennom denne utfordringen, bør du forbedre dine arbeidsstyrkeledelsesferdigheter og -evner.

Ikke velge riktige datamerkingsverktøy

Markedsstørrelsen på dataannoteringsverktøyene var over $ 1 milliarder i 2020, og dette tallet forventes å vokse med mer enn 30 % CAGR innen 2027. Den enorme veksten i datamerkingsverktøy er at det transformerer resultatet av AI og maskinlæring.

Verktøysteknikkene som brukes varierer fra et datasett til et annet. Vi har lagt merke til at de fleste organisasjoner begynner den dype læringsprosessen ved å fokusere på å utvikle interne merkeverktøy. Men veldig snart innser de at ettersom kommentarbehovet begynner å vokse, kan verktøyene deres ikke holde tritt. Dessuten er det dyrt, tidkrevende og praktisk talt unødvendig å utvikle interne verktøy.

I stedet for å gå den konservative måten med manuell merking eller investere i å utvikle tilpassede merkeverktøy, er det smart å kjøpe enheter fra en tredjepart. Med denne metoden er alt du trenger å gjøre å velge riktig verktøy basert på ditt behov, tjenestene som tilbys og skalerbarhet.

Overholder ikke retningslinjene for datasikkerhet

Overholdelse av datasikkerhet vil se en betydelig økning snart ettersom flere selskaper samler inn store sett med ustrukturerte data. CCPA, DPA og GDPR er noen av de internasjonale datasikkerhetsstandardene som brukes av bedrifter.

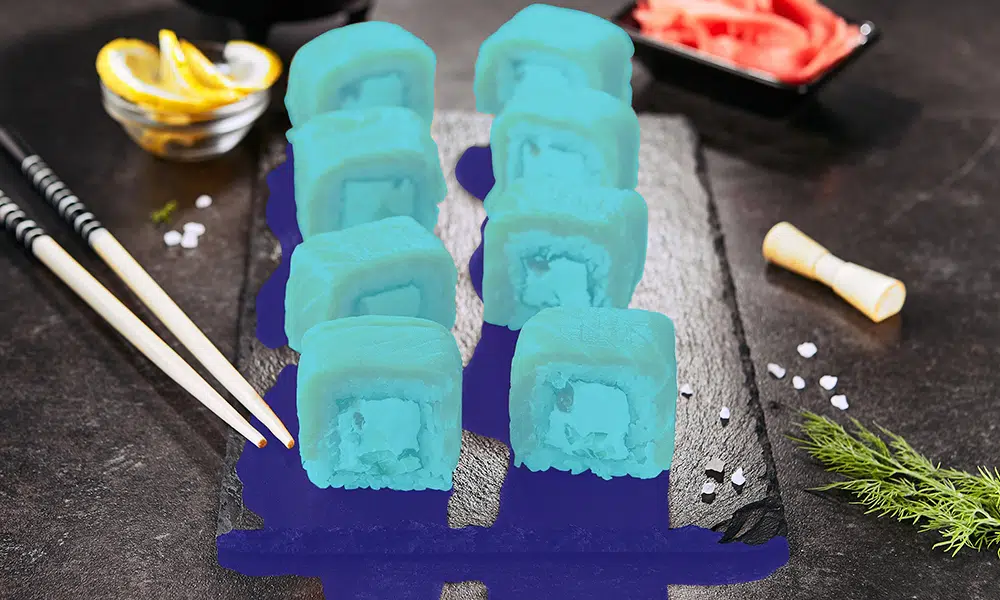

Presset for overholdelse av sikkerhet blir akseptert fordi når det gjelder merking av ustrukturerte data, er det forekomster av personopplysninger på bildene. I tillegg til å beskytte personvernet til forsøkspersonene, er det også viktig å sikre at dataene er sikret. Bedriftene må sørge for at arbeiderne, uten sikkerhetsgodkjenning, ikke har tilgang til disse datasettene og ikke kan overføre eller tukle med dem i noen form.

Sikkerhetsoverholdelse blir et sentralt smertepunkt når det gjelder å outsource merkeoppgaver til tredjepartsleverandører. Datasikkerhet øker kompleksiteten i prosjektet, og leverandører av merketjenester må overholde forskriftene til virksomheten.

Så venter ditt neste store AI-prosjekt på riktig datamerkingstjeneste?

Vi tror suksessen til ethvert AI-prosjekt avhenger av datasettene vi mater inn i maskinlæringsalgoritmen. Og hvis AI-prosjektet forventes å gi nøyaktige resultater og spådommer, er datamerking og merking av største betydning. Av outsourcing av dataannoteringsoppgavene dine, forsikrer vi deg om at du effektivt kan løse disse utfordringene.

Med vårt fokus på konsekvent å opprettholde datasett av høy kvalitet, tilby tilbakemeldinger med lukket sløyfe og administrere arbeidsstyrken effektivt, vil du kunne levere AI-prosjekter i toppklasse som gir et høyere nivå av nøyaktighet.

[Les også: Intern eller outsourcet datakommentar – som gir bedre AI-resultater?]

Når du merker datasett, kommer etikettørens subjektive sannhet inn. For eksempel kan deres erfaring, språk, kulturelle tolkninger, geografi og mer påvirke deres tolkning av data. Hver merker vil alltid gi et annet svar basert på sine egne skjevheter. Men subjektive data har ikke et "riktig eller galt svar - det er derfor arbeidsstyrken må ha klare standarder og retningslinjer når de merker bilder og andre data.

Når du merker datasett, kommer etikettørens subjektive sannhet inn. For eksempel kan deres erfaring, språk, kulturelle tolkninger, geografi og mer påvirke deres tolkning av data. Hver merker vil alltid gi et annet svar basert på sine egne skjevheter. Men subjektive data har ikke et "riktig eller galt svar - det er derfor arbeidsstyrken må ha klare standarder og retningslinjer når de merker bilder og andre data.

Presset for overholdelse av sikkerhet blir akseptert fordi når det gjelder merking av ustrukturerte data, er det forekomster av personopplysninger på bildene. I tillegg til å beskytte personvernet til forsøkspersonene, er det også viktig å sikre at dataene er sikret. Bedriftene må sørge for at arbeiderne, uten sikkerhetsgodkjenning, ikke har tilgang til disse datasettene og ikke kan overføre eller tukle med dem i noen form.

Presset for overholdelse av sikkerhet blir akseptert fordi når det gjelder merking av ustrukturerte data, er det forekomster av personopplysninger på bildene. I tillegg til å beskytte personvernet til forsøkspersonene, er det også viktig å sikre at dataene er sikret. Bedriftene må sørge for at arbeiderne, uten sikkerhetsgodkjenning, ikke har tilgang til disse datasettene og ikke kan overføre eller tukle med dem i noen form.