Datamerking eller datamerking, som du vet, er en evigvarende prosess. Det er ingen avgjørende øyeblikk du kan si at du ville slutte å trene AI-modulene dine fordi de har blitt perfekt nøyaktige og raske til å levere resultater.

Selv om lanseringen av den AI-drevne modulen bare er en milepæl, skjer AI-trening kontinuerlig etter lansering for å optimalisere resultater og effektivitet. På grunn av dette er organisasjoner plaget med bekymringen om å generere enorme mengder relevante data for maskinlæringsmodulene deres.

Det er imidlertid ikke den bekymringen vi skal diskutere i dag. Vi skal utforske utfordringene som oppstår når denne bekymringen generere data er fikset. Tenk deg at du har utallige kontaktpunkter for datagenerering. Det mer problematiske problemet du vil stå overfor på dette tidspunktet er kommentere så store datamengder.

Skalerbar datamerking er det vi skal belyse i dag fordi organisasjonene og teamene vi har snakket med alle har pekt oss på det faktum at disse interessentene synes det er mer utfordrende å bygge maskintillit enn å generere data. Og som du vet, kan maskinsikkerhet bygges bare gjennom riktig opplærte systemer støttet av nøyaktig annoterte data. Så la oss ta en titt på 5 store bekymringer som reduserer effektiviteten til datamerkingsprosesser.

5 virkelige utfordringer som utvanner innsatsen for datamerking

Arbeidsledelse

Vi har gjentatte ganger gjentatt at datamerking ikke bare er tidkrevende, men også arbeidskrevende. Eksperter på datakommentarer bruker utallige timer på å rense ustrukturerte data, kompilere dem og gjøre dem maskinlesbare. Samtidig må de sørge for at kommentarene deres er presise og av høy kvalitet.

Så organisasjoner står overfor utfordringen med å balansere både kvalitet og kvantitet for å få resultater som utgjør en forskjell og løser et formål. I slike tilfeller blir det ekstremt vanskelig og anstrengende å administrere arbeidsstyrken. Mens outsourcing hjelper, bedrifter som har dedikerte interne team for datanotering formål, møte hindringer som:

- Opplæring av ansatte for datamerking

- Fordeling av arbeid på tvers av team og fremme interoperabilitet

- Ytelses- og fremdriftssporing på både mikro- og makronivå

- Håndtere slitasje og omskolere nye ansatte

- Effektivisering av koordinering mellom dataforskere, annotatorer og prosjektledere

- Eliminering av kulturelle, språklige og geografiske barrierer og fjerning av skjevheter fra operasjonelle økosystemer og mer

Sporing av økonomi

Budsjettering er en av de mest avgjørende fasene i AI-trening. Den definerer hvor mye du er villig til å bruke på å bygge en AI-modul når det gjelder teknologistabel, ressurser, ansatte og mer, og hjelper deg deretter med å beregne nøyaktig avkastning. Nærme 26% av selskapene som våger seg på å utvikle AI-systemer mislykkes halvveis på grunn av feil budsjettering. Det er verken åpenhet om hvor penger pumpes inn eller effektive beregninger som gir sanntidsinnsikt til interessenter om hva pengene deres blir oversatt til.

Små og mellomstore bedrifter er ofte fanget i dilemmaet med betaling per prosjekt eller time og i smutthullet med å ansette SMB for merknad formål kontra å rekruttere en pool av mellommenn. Alle disse kan elimineres under budsjetteringsprosessen.

Overholdelse og overholdelse av personvern

Mens antallet brukstilfeller for AI øker, skynder bedrifter seg med å ri på bølgen og utvikle løsninger som hever liv og opplevelse. I den andre enden av spekteret ligger en utfordring som bedrifter i alle størrelser må ta hensyn til – datavernhensyn.

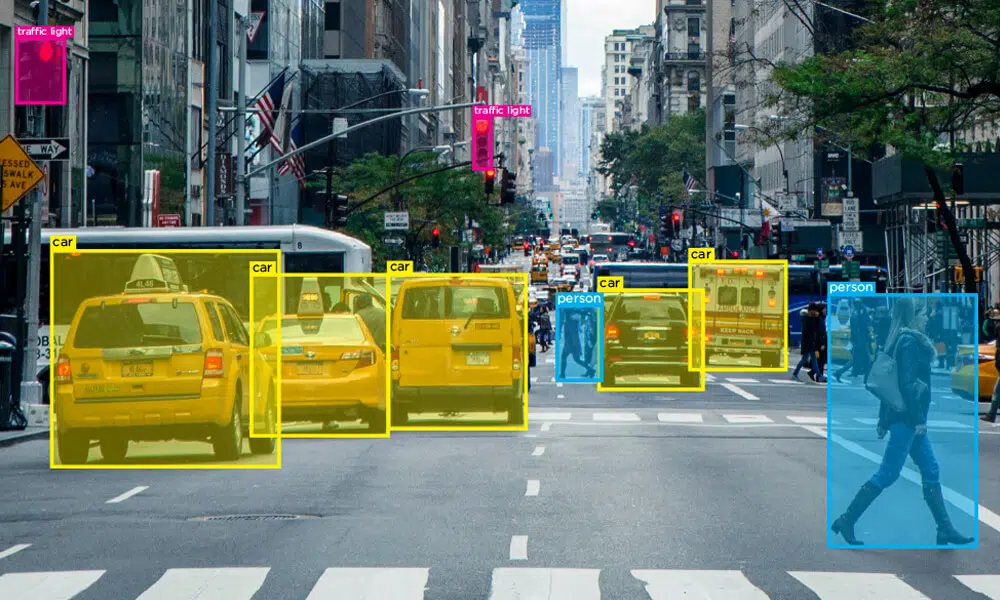

Du er kanskje kjent med GDPR, CCPA, DPA og andre retningslinjer, men det er nyere lover og overholdelse som utvikles og implementeres av nasjoner rundt om i verden. Når flere datamengder genereres, blir personvern avgjørende i datakommentarer ettersom data fra sensorer og datasyn genererer data som har ansikter til mennesker, konfidensielle detaljer fra KYC-dokumenter, nummerskilt på kjøretøy, lisensnummer og mer.

Dette presser behovet for riktig vedlikehold av personvernstandarder og overholdelse av rettferdig bruk av konfidensielle data. Teknisk sett bør et forsvarlig og sikkert miljø garanteres av virksomheter som forhindrer uautorisert tilgang til data, bruk av uautoriserte enheter i et datasikkert økosystem, ulovlige nedlastinger av filer, overføring til skysystemer med mer. Lover som regulerer personvern er intrikate, og man må passe på for å sikre at hvert enkelt krav oppfylles for å unngå juridiske konsekvenser.

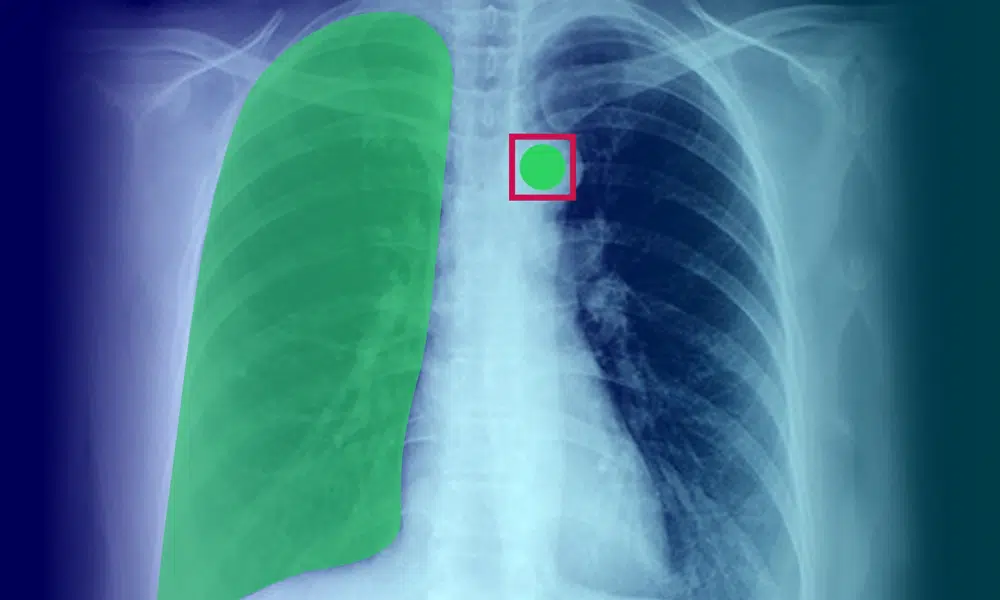

Smarte verktøy og assisterte merknader

Av de to forskjellige typene merknadsmetoder – manuell og automatisk, er en hybrid merknadsmodell ideell for fremtiden. Dette er fordi AI-systemer er flinke til å behandle enorme mengder data sømløst og mennesker er flinke til å påpeke feil og optimalisere resultater.

AI-assisterte verktøy og merknadsteknikker er solide løsninger på utfordringene vi står overfor i dag, da det gjør livet til alle interessenter som er involvert i prosessen enkle. Smarte verktøy lar bedrifter automatisere arbeidsoppgaver, pipelineadministrasjon, kvalitetskontroll av kommenterte data og tilby mer bekvemmelighet. Uten smarte verktøy ville personalet fortsatt jobbet med foreldede teknikker, og presset menneskelige timer betydelig for å fullføre arbeidet.

Håndtere konsistens i datakvalitet og kvantitet

En av de viktige aspektene ved vurdering av datakvalitet er å vurdere definisjonen av etiketter i datasett. For de uinnvidde, la oss forstå at det er to hovedtyper av datasett –

- Objektive data – data som er sanne eller universelle uavhengig av hvem som ser på dem

- Og subjektive data – data som kan ha flere oppfatninger basert på hvem som har tilgang til dem

Eksempelvis merking et eple som et rødt eple er objektivt fordi det er universelt, men ting blir komplisert når det er nyanserte datasett i hånden. Vurder et vittig svar fra en kunde på en anmeldelse. Annotatoren må være smart nok til å forstå om kommentaren er sarkastisk eller et kompliment for å merke den deretter. Sentimentanalyse moduler vil behandle basert på hva kommentatoren har merket. Så, når flere øyne og sinn er involvert, hvordan kommer ett lag til enighet?

Hvordan kan virksomheter håndheve retningslinjer og regler som eliminerer forskjeller og bringer inn en betydelig mengde objektivitet i subjektive datasett?

Innpakning Up

Det er ganske overveldende, ikke sant, mengden utfordringer dataforskere og annotatorer møter på daglig basis? Bekymringene vi har diskutert så langt er bare en del av utfordringen som stammer fra det konsekvente tilgjengelighet av data. Det er mye mer i dette spekteret.

Forhåpentligvis vil vi imidlertid styre i forkant av alt dette takket være utviklingen av prosesser og systemer innen datakommentarer. Vel, det er alltid outsourcing (shaip) tilgjengelige alternativer som gir deg data av høy kvalitet basert på dine behov.

Vi har gjentatte ganger gjentatt at datamerking ikke bare er tidkrevende, men også arbeidskrevende. Eksperter på datakommentarer bruker utallige timer på å rense ustrukturerte data, kompilere dem og gjøre dem maskinlesbare. Samtidig må de sørge for at kommentarene deres er presise og av høy kvalitet.

Vi har gjentatte ganger gjentatt at datamerking ikke bare er tidkrevende, men også arbeidskrevende. Eksperter på datakommentarer bruker utallige timer på å rense ustrukturerte data, kompilere dem og gjøre dem maskinlesbare. Samtidig må de sørge for at kommentarene deres er presise og av høy kvalitet. Du er kanskje kjent med GDPR, CCPA, DPA og andre retningslinjer, men det er nyere lover og overholdelse som utvikles og implementeres av nasjoner rundt om i verden. Når flere datamengder genereres, blir personvern avgjørende i datakommentarer ettersom data fra sensorer og datasyn genererer data som har ansikter til mennesker, konfidensielle detaljer fra KYC-dokumenter, nummerskilt på kjøretøy, lisensnummer og mer.

Du er kanskje kjent med GDPR, CCPA, DPA og andre retningslinjer, men det er nyere lover og overholdelse som utvikles og implementeres av nasjoner rundt om i verden. Når flere datamengder genereres, blir personvern avgjørende i datakommentarer ettersom data fra sensorer og datasyn genererer data som har ansikter til mennesker, konfidensielle detaljer fra KYC-dokumenter, nummerskilt på kjøretøy, lisensnummer og mer.