Som programvareutvikling som fungerer på en kode, utvikling som fungerer kunstig intelligens og maskinlæringsmodeller krever data av høy kvalitet. Modellene krever nøyaktig merkede og kommenterte data i flere stadier av produksjonen, da algoritmen må trenes kontinuerlig for å utføre oppgaver.

Men kvalitetsdata er vanskelig å få tak i. Noen ganger kan datasettene være fylt med feil som kan påvirke prosjektets resultat. Datavitenskap eksperter vil være de første til å fortelle deg at de bruker mer tid på å rense og skrubbe dataene enn på å evaluere og analysere dem.

Hvorfor er det feil i datasettet i utgangspunktet?

Hvorfor er det viktig å ha nøyaktige opplæringsdatasett?

Hva er typene av AI-treningsdatafeil? Og hvordan unngå dem?

La oss komme i gang med litt statistikk.

En gruppe forskere ved MIT Computer Science and Artificial Intelligence Lab gransket ti store datasett som har blitt sitert mer enn 100,000 XNUMX ganger. Forskerne fant at gjennomsnittlig feilprosent var ca 3.4 % på tvers av alle de analyserte datasettene. Det ble også funnet at datasettene led av ulike typer feil, for eksempel feilmerking av bilder, lyd og tekstfølelser.

Hvorfor er det feil i datasettet i utgangspunktet?

Tenk deg for eksempel å spørre kontorassistenten om å samle inn fullstendige detaljer om alle lokasjonsbedriftene dine og legge dem inn manuelt i et regneark. På ett eller annet tidspunkt vil det oppstå en feil. Adressen kan gå galt, duplisering kan oppstå eller datafeil kan skje.

Feil i data kan også oppstå hvis de samles inn av sensorer på grunn av utstyrsfeil, sensorforringelse eller reparasjon.

Hvorfor er det viktig å ha nøyaktige opplæringsdatasett?

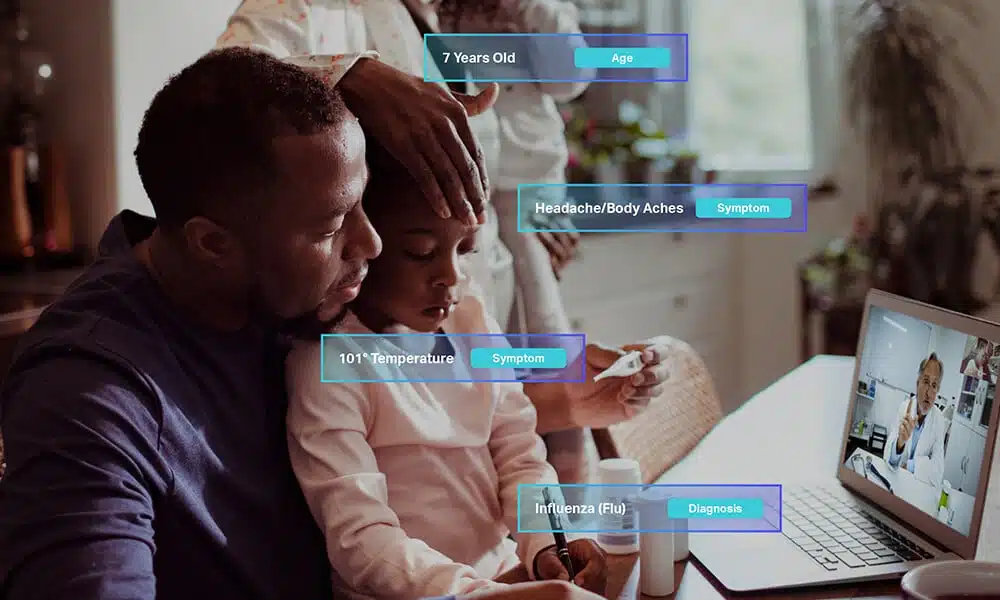

Alle maskinlæringsalgoritmer lærer av dataene du oppgir. Merkede og kommenterte data hjelper modellene med å finne relasjoner, forstå konsepter, ta beslutninger og evaluere ytelsen deres. Det er viktig å trene maskinlæringsmodellen din på feilfrie datasett uten å bekymre deg for kostnader tilknyttet eller tiden som trengs for trening. Som i det lange løp vil tiden du bruker på å innhente kvalitetsdata forbedre resultatet av AI-prosjektene dine.

Trening av modellene dine på nøyaktige data vil tillate modellene dine å lage nøyaktige spådommer og øke modellytelse. Kvaliteten, kvantiteten og algoritmene som brukes avgjør suksessen til AI-prosjektet ditt.

Hva er typene AI-treningsdatafeil?

Merkefeil, upålitelige data, ubalanserte data, databias

Vi skal se på de fire vanligste treningsdatafeilene og måtene å unngå dem på.

Merkefeil

Merkefeil er blant de fleste vanlige feil funnet i treningsdata. Hvis modellen er testdata har feilmerket datasett, vil den resulterende løsningen ikke være nyttig. Dataforskere ville ikke trekke nøyaktige eller meningsfulle konklusjoner om modellens ytelse eller kvalitet.

Merkefeil kommer i ulike former. Vi bruker et enkelt eksempel for å fremme poenget. Hvis dataannotatorene har en enkel oppgave med å tegne avgrensningsbokser rundt hver katt i bilder, kan følgende typer merkefeil sannsynligvis oppstå.

- Unøyaktig passform: Overmontering av modellen skjer når avgrensningsboksene ikke er tegnet så nær objektet (katten), og etterlater flere hull rundt den tiltenkte tingen.

- Manglende etiketter: I dette tilfellet kan kommentatoren savne å merke en katt på bildene.

- Feiltolkning av instruksjoner: Instruksjonene gitt til kommentatorene er ikke klare. I stedet for å plassere en avgrensningsboks rundt hver katt i bildene, plasserer kommentatorene en avgrensningsramme som omfatter alle kattene.

- Okklusjonshåndtering: I stedet for å plassere en avgrensningsboks rundt den synlige delen av katten, plasserer kommentatoren avgrensningsbokser rundt den forventede formen til en delvis synlig katt.

Ustrukturerte og upålitelige data

Omfanget av et ML-prosjekt avhenger av typen datasett det er trent på. Bedrifter bør bruke ressursene sine til å skaffe datasett som er oppdaterte, pålitelige og representative for det nødvendige resultatet.

Når du trener modellen på data som ikke er oppdatert, kan det gi langsiktige begrensninger i applikasjonen. Hvis du trener modellene dine på ustabile og ubrukelige data, vil det gjenspeile nytten av AI-modellen.

Ubalanserte data

Enhver dataubalanse kan forårsake skjevheter i modellens ytelse. Når du bygger høyytelses- eller komplekse modeller, bør treningsdatasammensetningen vurderes nøye. Dataubalanse kan være av to typer:

- Klasseubalanse: Klasseubalanse oppstår når treningsdata har svært ubalanserte klassefordelinger. Det er med andre ord ikke noe representativt datasett. Når det er klasseubalanser i datasettene, kan det forårsake mange problemer når du bygger med applikasjoner fra den virkelige verden.

For eksempel, hvis algoritmen trenes til å gjenkjenne katter, har treningsdataene kun bilder av katter på vegger. Da vil modellen prestere godt når den identifiserer katter på vegger, men vil gjøre det dårlig under forskjellige forhold. - Datanylighet: Ingen modell er helt oppdatert. Alle modeller gjennomgår en degenerasjon, som virkelige verden miljøet er i stadig endring. Hvis modellen ikke oppdateres regelmessig om disse miljøendringene, vil dens nytte og verdi sannsynligvis reduseres.

For eksempel, inntil nylig, kunne et overfladisk søk etter begrepet Sputnik ha gitt resultater om den russiske bæreraketten. Imidlertid ville søkeresultater etter pandemien være helt annerledes og fylt med den russiske Covid-vaksinen.

Bias i merkedata

Bias i treningsdata er et tema som stadig dukker opp nå og da. Dataskjevhet kan induseres under merkeprosessen eller av annotatorer. Dataskjevhet kan oppstå ved bruk av et betydelig heterogent team av annotatorer eller når en spesifikk kontekst er nødvendig for merking.

Redusere skjevhet er mulig når du har annotatorer fra hele verden eller regionspesifikke annotatorer som utfører oppgavene. Hvis du bruker datasett fra hele verden, er det stor mulighet for at kommentatorene gjør feil ved merking.

Hvis du for eksempel jobber med ulike retter fra hele verden, er det kanskje ikke en annotator i Storbritannia som er kjent med matpreferansene til asiater. Det resulterende datasettet ville ha en skjevhet til fordel for engelskmennene.

Hvordan unngå AI-treningsdatafeil?

Den beste måten å unngå opplæringsdatafeil på er å implementere strenge kvalitetskontroller på hvert trinn av merkeprosessen.

Du kan unngå datamerking feil ved å gi klare og presise instruksjoner til kommentatorene. Det kan sikre enhetlighet og nøyaktighet av datasettet.

For å unngå ubalanser i datasett, anskaffe nyere, oppdaterte og representative datasett. Sørg for at datasettene er nye og ubrukte fra før trening og testing ML-modeller.

Et kraftig AI-prosjekt trives med ferske, objektive og pålitelige treningsdata for å yte sitt beste. Det er avgjørende å sette inn ulike kvalitetskontroller og tiltak ved hvert merking og testing. Treningsfeil kan bli et betydelig problem hvis de ikke identifiseres og rettes opp før de påvirker prosjektets utfall.

Den beste måten å sikre kvalitets AI-treningsdatasett for ditt ML-baserte prosjekt er å ansette en mangfoldig gruppe annotatorer som har de nødvendige domenekunnskap og erfaring for prosjektet.

Du kan oppnå rask suksess med teamet av erfarne kommentatorer på Shaip som leverer intelligente merke- og merknadstjenester til forskjellige AI-baserte prosjekter. Ring oss, og sørg for kvalitet og ytelse i AI-prosjektene dine.